En los últimos años, la inteligencia artificial (IA) ha transformado múltiples aspectos de la tecnología y la vida cotidiana, incluyendo el ámbito de la seguridad informática. Herramientas de IA se han vuelto cada vez más comunes para ayudar a encontrar vulnerabilidades, simplificar procesos y automatizar tareas repetitivas. Sin embargo, esta democratización del acceso a la IA también ha traído consigo desafíos inesperados, como el incremento de reportes de bugs generados de forma automática pero poco útiles. Recientemente, Curl, proyecto ampliamente reconocido en el mundo del desarrollo de software y seguridad, ha tomado la decisión radical de prohibir las presentaciones de informes de vulnerabilidades generados o asistidos por inteligencia artificial a través de la plataforma HackerOne. Este cambio representa un punto de inflexión relevante para la gestión de reportes de seguridad y la interacción entre la comunidad y los proyectos abiertos y consolidados.

Curl, un proyecto líder en el ámbito de las transferencias de datos y protocolos de red, ha sido durante mucho tiempo un destino clave para investigadores de seguridad y desarrolladores que buscan contribuir con la mejora del software. Su programa de recompensas y reporte de vulnerabilidades en HackerOne ha permitido recibir informes valiosos para garantizar un producto confiable y seguro. Sin embargo, en algún momento el equipo responsable notó un aumento notable en la cantidad de reportes que parecían ser generados automáticamente por modelos de lenguaje como ChatGPT u otras herramientas similares. Estos informes, generalmente vagos, inexactos o sin relevancia práctica, provocaron un desgaste considerable en el equipo encargado de análisis y filtrado. La saturación causada por el volumen de reportes irrelevantes llevó al equipo liderado por Daniel Stenberg, creador y figura central del proyecto Curl, a implementar una política estricta: any report on HackerOne must declare if AI was used to assist or generate the submission.

En el caso de detectarse contenido AI que no aporte valor real, la respuesta es la expulsión inmediata del remitente. Esto no solo responde al problema operativo, sino que también protege los recursos humanos y materiales de la comunidad. El coste que representa examinar cada reporte es elevado y cuando una gran parte de ellos son irrelevantes, se convierte en un ataque continuo de denegación de servicio, o DDoS, no a nivel tecnológico, sino a nivel administrativo. Los expertos y usuarios de la comunidad han manifestado opiniones diversas ante esta medida. Algunos comprenden que la IA, aunque prometedora, aún no está en condiciones de reemplazar el análisis humano necesario para detectar y reportar vulnerabilidades reales y explotables.

La precisión y la experiencia que se requieren en esta labor van más allá de lo que puede ofrecer un sistema automatizado que no tiene contexto completo ni discernimiento ético. Otros ven esta política como un llamado de atención para quienes utilizan la IA sin la diligencia debida en la materia, haciendo un uso superficial y contraproducente que perjudica el ecosistema de seguridad. Uno de los puntos más críticos mencionados durante la discusión es el daño colateral en los programas de recompensas por bugs, los conocidos bug bounty. Existía la preocupación de que, al ser tan sencillo para una IA generar un reporte plausible pero errado, algunas personas pudieran aprovechar esta posibilidad para enviar un número significativo de falsas alarmas, generando ruido y, eventualmente, cualquier pago por error. Esto afecta tanto a los proyectos como a los expertos que brindan informes genuinos y valiosos, ya que desvirtúa la percepción de la utilidad de estos programas.

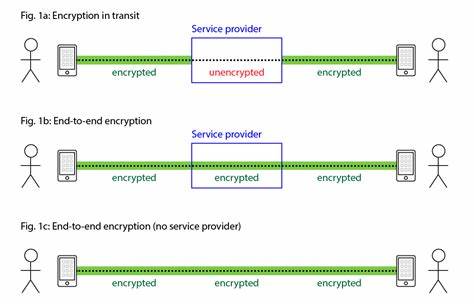

Además, esta situación refleja una problemática mayor en el uso de IA en contextos de seguridad y desarrollo: la falta de control sobre la calidad y veracidad de la información generada. Los modelos de lenguaje están entrenados con enormes conjuntos de datos, pero no tienen conciencia real ni capacidad para validar hechos en un entorno dinámico como es la seguridad informática. Por ello, aunque pueden ayudar en la investigación o sugerir hipótesis, el trabajo final debe pasar por el filtro riguroso del conocimiento especializado. Otra arista que resaltó la comunidad es la posibilidad de que estos reportes generados automáticamente sean, en realidad, parte de ataques deliberados para saturar y desviar la atención del equipo de Curl. La especulación apunta a que puede tratarse de una modalidad de spam computacional diseñado para generar desgaste y dificultad en la gestión de vulnerabilidades, afectando la eficiencia y propiciando errores humanos.

Esta amenaza híbrida combina la automatización con intenciones maliciosas, y obliga a repensar las defensas no solo técnicas, sino procedimentales. Por otro lado, se plantearon diversas propuestas paralelas relacionadas con la implementación de tarifas simbólicas para el envío de reportes, con la intención de desalentar el envío masivo sin fundamento. Estas ideas apuntan a una suerte de control de calidad económico, donde quienes verdaderamente investigan y generan reportes legítimos estarían dispuestos a pagar una pequeña cuota o arriesgarla como depósito, reembolsable solo si el reporte es válido. Esta medida tendría la ventaja de añadir una barrera para los que envían reportes por mera curiosidad o para aprovecharse del sistema, aunque también plantea retos logísticos y éticos, especialmente respecto a la accesibilidad y privacidad de los investigadores independientes o anónimos. En resumen, la decisión de Curl de prohibir formalmente los reportes generados por IA en HackerOne pone sobre la mesa una cuestión fundamental para el futuro del desarrollo seguro: el equilibrio necesario entre automatización y supervisión humana.

La tecnología avanza rápidamente y la inteligencia artificial tiene un enorme potencial de apoyo, pero sin una regulación y control adecuados, puede convertirse en un problema más que en una solución. La comunidad entera debe lidiar con estas tensiones y buscar métodos innovadores para proteger la integridad de los proyectos y la calidad del trabajo colaborativo. El caso de Curl también funciona como un llamado a la reflexión para otros proyectos de código abierto y plataformas vinculadas a la seguridad, para que evalúen la forma en la que manejan los reportes y colaboraciones asistidas por IA. Es probable que en el futuro se adopten mecanismos de verificación más estrictos, autenticación y filtros inteligentes que diferencien entre contribuciones legítimas y el ruido agotador producido por algoritmos. Finalmente, los desarrolladores y investigadores deben entender que el uso responsable de la inteligencia artificial es vital para evitar situaciones contraproducentes.

La herramienta debe ser vista como apoyo y no como sustituto del trabajo especializado, especialmente cuando de seguridad informática se trata. El compromiso con la calidad, la ética y la rigurosidad en los reportes es más importante que nunca para proteger los ecosistemas digitales que sustentan el mundo moderno. A medida que el debate sobre la IA y la ciberseguridad continúa evolucionando, el ejemplo de Curl servirá como un referente de cómo las comunidades técnicas pueden gestionar los desafíos del avance tecnológico sin sacrificar la calidad ni la confianza. La prohibición de informes generados automáticamente no es un rechazo a la tecnología en sí, sino una afirmación del valor insustituible del conocimiento humano en la lucha contra las amenazas digitales.