En el mundo actual de la inteligencia artificial, el uso eficiente de modelos de lenguaje a gran escala (LLM) es fundamental para desarrollar soluciones robustas y económicas. Microsoft GraphRAG, un sistema avanzado de generación aumentada por recuperación, ha ganado popularidad por su capacidad de garantizar respuestas precisas utilizando bases de datos semánticas. Sin embargo, uno de los retos más significativos para los desarrolladores ha sido la falta de visibilidad sobre el consumo de tokens y, en consecuencia, el costo asociado antes de ejecutar procesos de indexación masivos. La necesidad de abordar esta limitación llevó a la innovación en la integración de una característica para estimar con anticipación el uso de tokens y los costos de LLM en dicho pipeline, aportando un valor crucial para los equipos que trabajan con recursos limitados o grandes volúmenes de datos. Los modelos de lenguaje, fundamentalmente basados en el conteo y procesamiento de tokens, implican gastos monetarios directamente proporcionales a la cantidad de tokens utilizados.

Dado que el proceso de indexar datos en GraphRAG depende de múltiples llamadas a modelos para generar embeddings y resúmenes, el uso de tokens puede acumularse rápidamente. Por tanto, conocer con anticipación cuántos tokens se consumirán posibilita controlar gastos inesperados, mejorar la planificación presupuestaria y evitar sobregiros en los créditos disponibles para uso de APIs OpenAI. El flujo tradicional de Microsoft GraphRAG ofrecía un mecanismo potente para segmentar documentos, generar embeddings semánticos y crear índices que facilitan la recuperación inteligente de información mediante modelos LLM. Sin embargo, este sistema no proveía ninguna herramienta integrada que anticipara el gasto en tokens asociado a cada ejecución de indexación. Para desarrolladores en entornos con recursos limitados o para quienes manejan cantidades ingentes de datos, esta opacidad representaba una barrera significativa y una fuente de riesgo financiero.

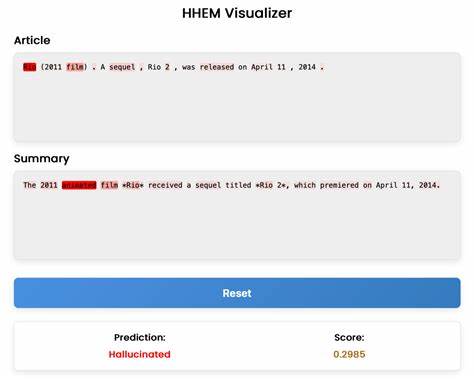

Como respuesta, se diseñó e implementó una funcionalidad basada en una interfaz de línea de comandos (CLI) que permite ejecutar una previsualización del consumo estimado de tokens y el costo monetario correspondiente antes de iniciar el proceso real de indexación. El comando principal acepta parámetros como la ruta raíz de los datos, un indicador para realizar la estimación y una configuración que determina el número promedio de tokens en la salida por cada fragmento procesado. Esto otorga al usuario un reporte detallado con información sobre el modelo de embedding, cantidad de tokens de entrada y salida, así como el coste aproximado expresado en dólares estadounidenses. Detrás de escena, esta funcionalidad se apoya en la clase TokenTextSplitter, que simula la lógica de fragmentación que GraphRAG emplea durante la indexación. Además, para mantener la precisión y actualización en los precios, utiliza un archivo JSON alojado que contiene tarifas actualizadas de OpenAI, conciliando diversos modelos y permitiendo mecanismos de fallback para aquellos que no estén listados explícitamente.

Si, por ejemplo, un usuario selecciona un modelo experimental o en previsualización como gpt-4o-preview, el sistema automáticamente reemplaza la tarifa por la del modelo más similar disponible, asegurando así que la estimación sea siempre coherente y precisa. Es importante destacar que la estimación resulta conservadora, incluyendo no solo el conteo real de tokens derivados del embedding sino también una aproximación configurable basada en la cantidad esperada de tokens que producirán las salidas generadas por las APIs para cada fragmento. Esta estrategia permite cubrir escenarios poco previsibles y resulta especialmente útil para evitar sorpresas en el uso real, ofreciendo un límite superior prudente que se alinea con el reporte final del panel de control de OpenAI. Un aspecto técnico interesante involucrado en esta solución es el uso de la biblioteca tiktoken, que representa la fuente oficial para el tokenizado usado por los modelos de OpenAI. Aunque la simulación mediante TokenTextSplitter es suficiente para adelantar el proceso de estimación, la reconexión y verificación utilizando tiktoken garantiza la correlación exacta con el consumo que luego reflejará la facturación.

Además, durante el desarrollo de esta funcionalidad, se evidenciaron desafíos como evitar errores relacionados con bucles de eventos asincrónicos y la correcta normalización y conversión de precios originalmente almacenados en centavos a dólares. La importancia de esta mejora va más allá del apartado técnico; aporta una transparencia vital y capacidad de predicción que facilita la toma de decisiones inteligentes en la arquitectura y despliegue de sistemas de generación aumentada por recuperación (RAG). Hoy día, donde la escalabilidad y el control de costos son criterios clave en proyectos IA, esta característica sirve para mitigar riesgos financieros y optimizar la asignación eficiente de recursos. El desarrollo de esta capacidad no sólo impulsa la experiencia del usuario dentro del ecosistema Microsoft GraphRAG sino que también posiciona la herramienta para alcanzar los estándares que se esperan de sistemas RAG robustos en producción, capaces de manejar grandes volúmenes de información sin perder la trazabilidad ni el control económico. Para la comunidad de desarrolladores, esta innovación representa una invitación a explorar más a fondo el potencial combinado de LLMs y técnicas de indexación avanzada, con la confianza de que las herramientas disponibles responderán a las necesidades tanto técnicas como financieras.

Además, la apertura de este aporte mediante un pull request público incentiva la colaboración y mejora continua del proyecto, reflejando el espíritu de la innovación abierta y el avance constante en la inteligencia artificial. En resumen, la incorporación de una funcionalidad que permite anticipar la cantidad de tokens y su costo asociado transforma el proceso de indexación en Microsoft GraphRAG, brindando una capa adicional de seguridad, control y eficiencia. Este avance no solo facilita la adopción de tecnologías LLM en proyectos de diversos tamaños, sino que también impulsa mejores prácticas en la gestión del consumo computacional y financiero de modelos de lenguaje, consolidando un paso decisivo hacia soluciones de inteligencia artificial realmente sostenibles y escalables.