En el mundo de la inteligencia artificial y la programación de alto rendimiento, la eficiencia en la generación de código es una ventaja competitiva clave. Devin, un innovador en el espacio de modelos de lenguaje para programación, ha lanzado su primer modelo open source llamado Kevin-32B, que ha logrado superar el rendimiento O3, reconocido como uno de los niveles más altos de optimización en compiladores. Este avance no solo marca un hito en la capacidad de los modelos para escribir código eficiente, sino que también abre una puerta abierta para la comunidad de desarrolladores en el ámbito de CUDA y programación paralela. Kevin-32B es un modelo de 32 mil millones de parámetros finetuneado específico para la generación de kernels CUDA eficientes. Los kernels CUDA son pequeños programas que se ejecutan en la GPU para realizar tareas computacionales altamente paralelas, vitales en procesos que involucran cálculos intensos como aprendizaje automático, simulaciones físicas o procesamiento de imágenes.

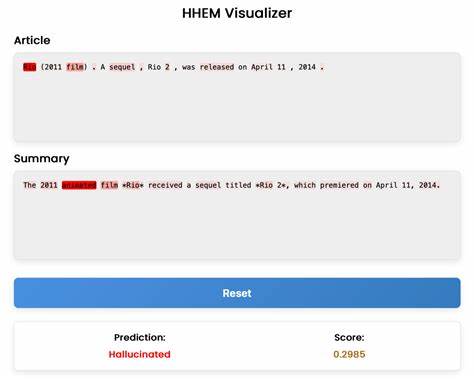

La eficiencia de estos kernels impacta directamente en la velocidad y rendimiento general de las aplicaciones que dependen de GPU. La novedad de Kevin-32B radica en su entrenamiento a través de KernelBench, un benchmark especializado que mide la calidad y eficiencia de kernels CUDA generados automáticamente. El modelo ha sido entrenado con un método innovador de aprendizaje por refuerzo en múltiples turnos, lo que significa que no solo aprende de ejemplos estáticos sino que mejora su rendimiento en función de la retroalimentación recibida al evaluar la eficiencia real del código generado. Este tipo de entrenamiento hace que Kevin-32B sea más robusto y capaz de optimizar soluciones teniendo en cuenta el contexto de ejecución en GPU, un desafío que pocos modelos han podido afrontar. La comparación con optimizaciones del compilador O3 es relevante porque O3 representa la bandera más alta de optimización que compilan los códigos, intentando extraer el máximo rendimiento sin comprometer la precisión o funcionalidad.

Que Kevin-32B haya superado a O3 en varios casos indica que los modelos de lenguaje pueden no solo replicar patrones comunes de codificación sino también descubrir nuevas formas de optimización que superan a las tradicionales, basadas en reglas rígidas. Este modelo es parte del ecosistema de Cognition AI y se basa en el preentrenamiento de modelos Qwen, conocido por su robustez y versatilidad. Posteriormente fue finetuneado específicamente para el objetivo de escribir kernels CUDA usando conjuntos de datos especializados y métricas de calidad detalladas de KernelBench. El uso de formatos como Safetensors para su distribución indica que mantiene un equilibrio entre seguridad y eficiencia en su almacenamiento y manejo. Además, Kevin-32B es una muestra del poder colaborativo y abierto de la comunidad de la inteligencia artificial actual.

Al ser open source, cualquier desarrollador interesado puede acceder, probar y mejorar el modelo, impulsando así un ecosistema más dinámico en la generación automática de código optimizado para hardware especializado. Las implicaciones de este avance son múltiples. Para el desarrollador, significa acceso a una herramienta que puede acelerar la escritura y mejora continua de código CUDA, reduciendo tiempos de desarrollo y optimizando el rendimiento sin necesidad de un profundo conocimiento en optimización manual. Para la industria, representa un paso hacia sistemas más autónomos capaces de generar soluciones altamente eficientes, lo que puede traducirse en costos menores en computación y mayor sostenibilidad energética. Por otro lado, al estar disponible en plataformas como Hugging Face, Kevin-32B puede integrarse con diferentes flujos de trabajo y herramientas de machine learning, haciendo que su adopción sea más sencilla y extendida.

La ausencia de despliegue en proveedores de inferencia aún abre una oportunidad para servicios externos interesados en incorporar este modelo para ofrecer soluciones de generación automática de código en la nube. En conclusión, Kevin-32B refleja una nueva generación de modelos open source que no solo inmita capacidades humanas en programación, sino que las supera en tareas específicas de alto impacto como la creación de kernels CUDA optimizados. La combinación de un entrenamiento basado en aprendizaje por refuerzo, el uso de benchmarks especializados como KernelBench y la apertura de su código al público aseguran que este desarrollo sea una referencia para futuros modelos y aplicaciones en programación automática apoyada por inteligencia artificial. Devin y Cognition AI han abierto un camino prometedor en la intersección entre machine learning y desarrollo de software de alto rendimiento, marcando un antes y un después en cómo se conciben y aplican los algoritmos para GPUs.