En el vertiginoso mundo de la inteligencia artificial, la confiabilidad y precisión de los modelos se han convertido en pilares fundamentales para su adopción masiva en aplicaciones reales. Los avances tecnológicos han permitido desarrollar agentes de IA que no solo responden a interrogantes complejos sino que también ejecutan flujos de trabajo automatizados. Sin embargo, uno de los principales desafíos sigue siendo garantizar respuestas fieles y consistentes, sobre todo cuando los modelos enfrentan tareas complejas o extensos conjuntos de instrucciones. En este contexto surge TSCE, o Two-Step Contextual Enrichment, acompañada de la innovadora propuesta de Anclas Hiperdimensionales, dos herramientas que están revolucionando la forma en que los agentes de inteligencia artificial operan de manera confiable y escalable. TSCE es un marco mecánico en dos fases pensado para reducir de forma drástica las alucinaciones, los errores de instrucción y las fallas en el formato, sin necesidad de realizar ajustes complejos en el modelo base.

Su esencia reside en un proceso en dos etapas que permite al modelo concentrarse en generarar respuestas precisas y fieles a las instrucciones dadas. La primera fase produce lo que se denomina "Embedding Space Control Prompt" (ESCP), un tipo de compresión semántica que condensa de manera efectiva la información contextual y reduce la dispersión del espacio vectorial de salida generado por el modelo. Esta compresión en la fase inicial es clave para evitar que el modelo divague o tome atajos erróneos en la generación de texto. Al tratarse de un “bloque opaco” de tokens vectoriales densos, la ESCP funciona como una ancla que contiene y restringe el recorrido semántico de la generación posterior. De tal forma, en la segunda fase, el modelo vuelve a evaluar la instrucción original junto con esta ancla hiperdimensional, produciendo una respuesta mucho más enfocada y coherente con la intención inicial, con una temperatura de generación muy baja para garantizar determinismo y reducir variabilidad indeseada.

Un punto fundamental para entender TSCE es que este doble pase conlleva un coste computacional aproximado doble con respecto a una generación de una sola etapa. Sin embargo, el beneficio en la mejora de la calidad y la reducción de errores justifica ampliamente esos recursos adicionales, especialmente cuando la precisión es crítica. Los resultados de implementación de TSCE han demostrado un aumento significativo en métricas de éxito como la reducción de violaciones de políticas, mejora en tareas matemáticas y razonamiento y una menor tasa de alucinaciones. Por ejemplo, en el caso de GPT-3.5, la aplicación de TSCE incrementó la tasa de éxito en tareas matemáticas y de formato de un 49% a un 79%.

Para GPT-4.1, se redujeron las violaciones de políticas de un 50% a tan solo un 6%, resultado que evidencia el impacto real de esta tecnología para industrias con alto requerimiento de confiabilidad. En modelos de código abierto como Llama-3 de 8 mil millones de parámetros, se ha observado una mejora del 69% al 76% en acciones de razonamiento mixto, además de habilitar procesos de razonamiento en cadena (Chain-of-Thought) que antes eran limitados. Más allá de TSCE, el concepto de anclas hiperdimensionales se refiere precisamente a la representación densa y comprensiva que sirve para guiar y estabilizar el proceso generativo del modelo. Estas anclas funcionan en un espacio vectorial mucho más allá de las dimensiones convencionales, donde se almacenan mapas semánticos que controlan el comportamiento del agente y limitan posibles desviaciones.

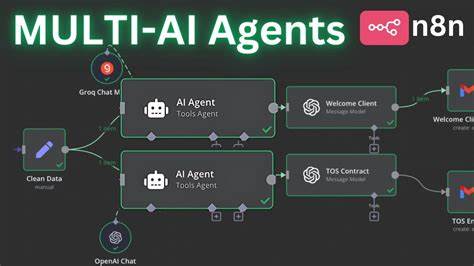

En el marco de TSCE, la ESCP actúa como tal ancla, manteniendo el recorrido de generación dentro de límites que aseguran fidelidad y estructura. La combinación de estas técnicas permite a los agentes de IA desplegar flujos de trabajo complejos y confiables, fundamentales para sectores donde la precisión y el cumplimiento normativo son no negociables, tales como el jurídico, financiero o el sector salud. De hecho, la reducción de alucinaciones y desviaciones conceptuales disminuye riesgo operativo y mejora la adoptabilidad de soluciones de inteligencia artificial en escenarios empresariales de producción. Otro aspecto importante es la flexibilidad del sistema TSCE, que puede integrarse con múltiples proveedores de modelos, incluyendo la API de OpenAI, despliegues en Azure OpenAI, Ollama o vLLM. Además, la arquitectura permite personalizar los prompts en ambas fases, facilitando ajustes específicos para variadas tareas o dominios, lo cual amplía su aplicabilidad.

Desde la perspectiva del desarrollo y la implementación, TSCE cuenta con herramientas que permiten comparar respuestas tradicionales y mejoradas, así como visualizaciones basadas en técnicas de reducción de dimensionalidad como t-SNE para analizar la convergencia semántica y la reducción de entropía en las salidas. Estas métricas y visualizaciones son clave para validar el impacto de TSCE en diferentes conjuntos de pruebas y para afinar las plantillas de prompts. Por supuesto, existen preguntas abiertas y áreas para futuro desarrollo. Una línea potencial es la exploración de ESCP recursivos, donde se evalúa si repetir la fase uno sobre el resultado previamente comprimido puede mejorar aún más la concentración semántica o si, por el contrario, se generan errores acumulativos. Otro interés radica en la automatización del ajuste de prompts, usando técnicas de prompt tuning automático, para encontrar configuraciones ideales sin necesidad de intervención humana constante.