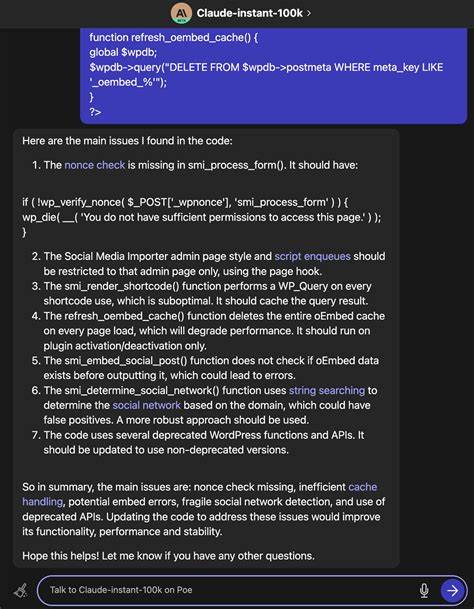

En la era actual, donde los modelos de lenguaje grande (LLMs) han revolucionado la interpretación y generación de textos e imágenes, surge un reto significativo en la forma en que estos modelos manejan la información tabular. Aunque se ha avanzado considerablemente en procesar datos textuales y visuales, la explotación de datos provenientes de tablas —como conjuntos de datos estadísticos, encuestas y bases administrativas— sigue siendo limitada. Ello se debe, en gran medida, a la dificultad inherente de representar tablas de manera que los LLMs puedan capturar la profundidad y complejidad de la información contenida en ellas. La mayoría de los modelos no integran eficazmente el conocimiento detallado que reside en estas estructuras, más allá de utilizar algunos resúmenes estadísticos simple o información publicada a partir de ellas. El problema fundamental radica en cómo representar las tablas para que sean accesibles y útiles para los LLMs.

Un método común, pero insuficiente, es transformar cada fila de una tabla en una oración —un enfoque que simplifica el formato de la tabla a un conjunto de textos. Sin embargo, esta simplificación provoca la pérdida de relaciones críticas entre los datos, ya que se pasa por alto la estructura tabular y sus interdependencias. Además, si no se identifica adecuadamente el diseño del conjunto, como el formato largo o ancho de la tabla, pueden repetirse datos correlacionados de forma redundante, lo que perjudica aún más la calidad del análisis. Una solución más prometedora involucra la aplicación de técnicas de destilación mecánica que simplifiquen la tabla a través de resúmenes univariados, bivariados y multivariados. Esta aproximación también puede incluir la generación de estadísticas descriptivas como medias, correlaciones y agrupaciones, proporcionando así una visión condensada y representativa del contenido original.

Para llevar a cabo esto efectivamente, es crucial poseer un entendimiento previo sobre la estructura y origen de los datos, lo que a menudo se facilita mediante diccionarios de datos o metadatos que describen la naturaleza y forma del conjunto. A partir del entendimiento de la estructura, el siguiente paso implica determinar las preguntas relevantes que se le podrían hacer a los datos para extraer insights significativos. Aquí la inteligencia artificial juega un papel crucial, ya que se puede entrenar al modelo para que proponga interrogantes útiles basados en la información existente. Estas preguntas guían la generación de resúmenes y análisis que se ajustan al contexto y al propósito del uso de los datos. Finalmente, se elaboran los resúmenes mecánicos y se responden las preguntas previamente generadas, proporcionando descripciones detalladas sobre los métodos estadísticos aplicados y los resultados obtenidos.

Adicionalmente, la visualización de la información mediante gráficos aporta una capa extra de comprensión que facilita el entendimiento humano y la interpretación de patrones o tendencias que podrían pasar desapercibidos en tablas crudas. Este proceso, aunque poderoso, presenta limitaciones naturales. La complejidad intrínseca de los datos y la variedad de posibles preguntas que se pueden plantear hacen que incluso con un sistema sofisticado la cobertura sea necesariamente parcial. La cantidad de interrogantes que un conjunto de datos puede soportar es virtualmente infinita, y por ello, se requiere un equilibrio entre profundidad, relevancia y factibilidad en el análisis. Aplicar esta metodología en Repositorios de Recuperación de Información Basada en Recuperación (RAGs) y para complementar los llamados “datos del mundo”, que a menudo están sesgados hacia resultados impactantes o relevantes, representa una oportunidad significativa.

![NRC: Long-Term Cooling and Unattended Water Makeup of Spent Fuel Pools [pdf]](/images/AD55B988-1529-44F7-A323-EE3D76A1140B)