La programación informática es una actividad especializada que demanda una alta capacitación y experiencia para alcanzar niveles óptimos de productividad, precisión e integración. Durante décadas, la comunidad de inteligencia artificial ha buscado desarrollar herramientas automatizadas para facilitar la labor de los programadores, conduciendo al surgimiento de un área denominada síntesis de programas. Esta disciplina se centra en el proceso automático de generación de programas que satisfacen objetivos específicos, lo que implica transformar diversas formas de entradas en código funcional y correcto. La inteligencia artificial híbrida emerge como una solución poderosa al combinar dos enfoques muy diferentes. Por un lado, se encuentra la inteligencia simbólica, que utiliza reglas, lógica y estructuras formales similares a la programación tradicional.

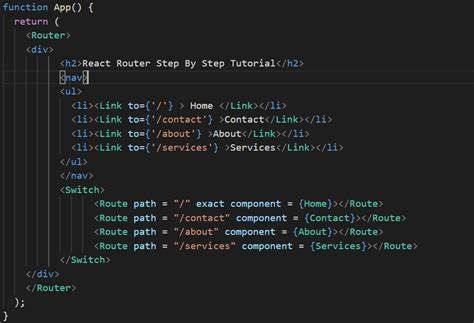

Por otro lado, está la inteligencia conexionista, representada principalmente por redes neuronales y modelos de lenguaje extenso (LLM), conocidos por su capacidad para generalizar patrones a partir de datos. Integrar estas dos estrategias permite aprovechar lo mejor de cada una para abordar la complejidad de la generación automática de programas. La síntesis de programas funciona tomando una entrada, que puede adoptar variadas formas, y produciendo un conjunto de instrucciones en un lenguaje formal que un motor simbólico puede interpretar y ejecutar. Entre los tipos de entrada más comunes están las especificaciones formales, ejemplos de programación, descripciones en lenguaje natural y lenguajes específicos de dominio (DSL). Cada tipo presenta sus propios desafíos y ventajas para el proceso de generación.

Las especificaciones formales constituyen un punto de partida riguroso donde los requisitos se definen mediante lenguajes lógicos o fragmentos de código ejecutables que establecen restricciones precisas al programa generado. Proyectos como el desafío SyGus ejemplifican este método, donde se plantean las condiciones semánticas y sintácticas que la síntesis de programas debe cumplir para ser considerada correcta. Sin embargo, la formalidad y precisión exigida pueden limitar el ámbito de aplicación o requieren un esfuerzo considerable para definir correctamente las especificaciones. Otra modalidad de síntesis recibe el nombre de programación por ejemplo (PBE, por sus siglas en inglés), donde se proporcionan pares concretos entrada-salida que el programa debe reproducir. Este enfoque es especialmente útil cuando no existen especificaciones formales claras, pero sí ejemplos que reflejen el comportamiento esperado.

Uno de los desafíos aquí radica en que el sistema no busca replicar el código exacto, sino un programa que produzca los mismos resultados para dichas entradas, lo que conlleva la necesidad de validar múltiples soluciones candidatas y descartar las incorrectas mediante técnicas de filtrado y verificación. El uso del lenguaje natural para guiar la síntesis de programas ha ganado terreno gracias a los avances en los grandes modelos de lenguaje, capaces de interpretar descripciones breves y traducirlas en código viable. A pesar de que el lenguaje humano es intrínsecamente ambiguo y impreciso para especificar programas complejos, los LLMs pueden capturar matices contextuales y generar soluciones plausibles, abriendo el camino para interacciones más accesibles a usuarios sin formación técnica profunda. Además, en la síntesis se favorece el uso de lenguajes específicos de dominio (DSL), los cuales reducen el espacio de búsqueda al limitar la expresividad a construcciones significativas y relevantes para una tarea particular. Los DSLs facilitan la generación de programas legibles, evitando el código redundante o boilerplate, y optimizan la eficiencia computacional al focalizar la exploración dentro de un conjunto acotado de posibilidades.

Los métodos para síntesis de programas pueden clasificarse en tres grandes categorías: totalmente simbólicos, totalmente neuronales y híbridos. Los enfoques simbólicos tradicionales utilizan algoritmos que exploran exhaustivamente el espacio de soluciones sin basarse en patrones aprendidos. Su principal limitación es la lentitud y la dificultad de escalar a problemas con amplias posibilidades o alto grado de complejidad. Por el contrario, los métodos completamente neuronales apoyados en redes profundas y LLMs cuentan con la capacidad de generalizar y aproximar funciones complejas, permitiendo una generación rápida bajo ciertas condiciones. Sin embargo, suelen carecer de la precisión que exige la ejecución formal del código y requieren grandes cantidades de datos de entrenamiento.

La generación de múltiples candidaturas y el posterior filtrado es una práctica común para mitigar errores, aunque impacta sobre el rendimiento. La fusión de ambos mundos, concretada en la inteligencia artificial neuro-simbólica, ofrece una combinación complementaria. En esta alianza, las redes neuronales aportan intuición y heurísticas probabilísticas que dirigen la búsqueda en el espacio de programas, mientras que los métodos simbólicos realizan verificaciones rigurosas y construyen las soluciones mediante composiciones lógicas. Esta colaboración recuerda la dicotomía entre el pensamiento rápido e intuitivo y el razonamiento pausado y analítico, lo que se traduce en sistemas más eficientes y robustos para la síntesis. Uno de los algoritmos fundamentales en este contexto es la síntesis inductiva guiada por contraejemplos (CEGIS).

En este proceso, se genera un candidato de programa que luego es sometido a verificación. Si el programa no cumple con las especificaciones, se identifica un contraejemplo que evidencia el fallo y se utiliza para refinar la búsqueda posterior, cerrando así un ciclo iterativo de mejora. La búsqueda de soluciones puede seguir estrategias ascendentes (bottom-up) o descendentes (top-down). En el enfoque top-down, el problema complejo se descompone en subproblemas más pequeños y se emplean heurísticas para evitar ramas inútiles, aspectos que las redes neuronales pueden facilitar mediante evaluaciones probabilísticas. El bottom-up inicia desde componentes simples, combinándolos por etapas, proceso cercano a la forma en que los programadores humanos construyen código mediante funciones y módulos progresivamente más complejos.

Las heurísticas probabilísticas tienen un papel crucial en la guía de la búsqueda, especialmente cuando se aprovechan gramáticas libres de contexto probabilísticas (pCFG) que establecen las reglas sintácticas con pesos asociados, determinando la probabilidad de seleccionar ciertas expansiones en la generación del programa. Estas heurísticas suelen derivarse del análisis de patrones frecuentes y atributos presentes en bases de datos de programas de entrenamiento. Sistemas emblemáticos que ejemplifican estos principios incluyen DeepCoder, que utiliza vectores de atributos para priorizar funciones en búsqueda top-down; Neural-Guided Deductive Search, que combina programación por ejemplo con modelos neuronales para clasificar ramificaciones potenciales; y CrossBeam, que adopta una búsqueda bottom-up guiada por redes neuronales enfocadas en la combinación de operaciones previas. Más recientemente, la integración de modelos de lenguaje extenso (LLM) ha revolucionado esta área, al facilitar la generación de código a partir de descripciones en lenguaje natural y brindar capacidades cognitivas amplias. No obstante, estos modelos enfrentan desafíos como la falta de consistencia en respuestas, sensibilidad a la formulación de los prompts y la dificultad para mantener razonamientos lógicos estables.

Sin embargo, su habilidad para capturar contexto largo y conocimientos generalizados aporta un valor significativo cuando se combina con motores simbólicos formales. La arquitectura transformadora, base de los principales LLM, proporciona una memoria de largo alcance y embebidos complejos que codifican información relevante para generar programas más coherentes y ajustados a la tarea. Métodos como la generación aumentada por recuperación (RAG) exploran la similitud semántica para apoyar el proceso, aunque la naturaleza formal y estructurada del código limita su utilidad directa. En el terreno de métodos híbridos avanzados, se destaca Alpha Geometry, que aprovecha un modelo transformador para generar construcciones auxiliares en la resolución automática de problemas geométricos a través de pruebas formales. Asimismo, iLLM-synth utiliza LLM como generadores interactivos de funciones auxiliares y ajustes dinámicos del espacio de búsqueda, integrando estas sugerencias en gramáticas probabilísticas que respaldan búsquedas eficientes.

HySynth representa un ejemplo de método bottom-up que primero interpola posibles programas mediante LLM, creando gramáticas probabilísticas para guiar una búsqueda dinámica que prioriza subcomponentes con menor costo computacional. Estas técnicas optimizan la generación, minimizando redundancias y maximizando la eficiencia. El avance de la inteligencia artificial híbrida para la generación automática de programas abre un panorama prometedor en múltiples aplicaciones, desde la automatización de tareas rutinarias hasta la creación de sistemas inteligentes que pueden adaptarse y aprender de manera autónoma. Los retos todavía son numerosos, incluyendo mejorar la precisión de modelos neuronales, garantizar la interpretabilidad y adaptarse a dominios específicos complejos, pero la fusión de enfoques simbólicos y estadísticos está demostrando ser una vía efectiva. Finalmente, la síntesis de programas está en su umbral hacia una nueva era donde la colaboración humano-máquina se ve potenciada por herramientas inteligentes capaces de transformar especificaciones abstractas en código funcional con mínimas intervenciones humanas.

Los desarrollos en inteligencia artificial híbrida prometen transformar radicalmente la forma en que se concibe y realiza la programación, acercándola a usuarios con diversos niveles de expertise y ampliando el alcance de la innovación tecnológica.