En los últimos meses, muchos usuarios que utilizan Azure OpenAI han reportado problemas recurrentes de latencia y tiempos de espera excesivos que afectan la experiencia con los modelos más avanzados, como GPT-4. Estos inconvenientes están generando preocupación en desarrolladores y empresas que dependen de esta infraestructura para la ejecución de aplicaciones críticas. A pesar de que la página de estado oficial de Azure OpenAI indica que los servicios están operativos, múltiples usuarios en diversos foros, incluyendo comunidades como Hacker News, han señalado desde hace semanas que experimentan lentitud y hasta fallos por timeout en múltiples suscripciones y entornos de aplicación. Este fenómeno plantea una serie de interrogantes esenciales para quienes integran capacidades de inteligencia artificial en sus productos y servicios en la nube. Comprender el origen de estos problemas es clave para anticipar retos y adaptar estrategias que minimicen el impacto en la productividad y satisfacción del usuario final.

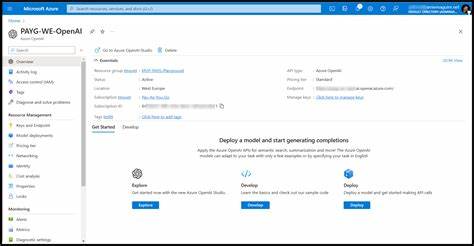

Azure OpenAI representa una alianza estratégica entre Microsoft Azure y OpenAI para facilitar el acceso a poderosos modelos de lenguaje natural. Su atractivo radica en ofrecer desde plataformas robustas, escalables y con soporte empresarial, hasta la inclusión de capacidades de inteligencia artificial generativa en proyectos diversos. El uso de modelos GPT-4 en esta plataforma supone una ventaja competitiva para muchas organizaciones que desean incorporar IA avanzada en áreas como atención al cliente, generación de contenido, análisis de datos y automatización de tareas complejas. No obstante, la aparición de latencia y desconexiones inesperadas está sumando una capa de incertidumbre que afecta procesos dependientes de respuestas rápidas y fiables. El problema de latencia en plataformas en la nube puede derivarse de múltiples factores.

En primer lugar, la sobrecarga temporal de los servicios debido a un aumento súbito en la demanda puede causar congestión en los servidores que alojan los modelos de IA. Esto es común cuando el interés por utilizar nuevas tecnologías crece y las infraestructuras no escalan tan rápidamente como la demanda. Además, interrupciones en la red o en el pipeline de procesamiento de solicitudes pueden generar tiempos de respuesta mayores a los normales, llevando a que las aplicaciones detecten pérdidas de comunicación o fallos. Otro factor potencial es la configuración interna de las aplicaciones o las limitaciones establecidas en las cuotas de uso y las políticas de acceso a los recursos. Cuando las solicitudes superan ciertos límites o no se administran adecuadamente los tokens y tiempos definidos, es probable que las plataformas implementen bloqueos preventivos o restrinjan el acceso para garantizar la estabilidad global del servicio.

En algunos casos, el diseño de la arquitectura del sistema donde esté integrado Azure OpenAI también puede ser determinante. Por ejemplo, aplicaciones con lógica pesada antes o después de la llamada a la API pueden introducir demoras que aparentan ser problemas del servicio cuando la raíz está en el sistema local. Frente a estos problemas, los expertos recomiendan adoptar buenas prácticas para mitigar el impacto y asegurar el máximo aprovechamiento de la plataforma. Es fundamental monitorear constantemente la latencia y el uso de recursos mediante las herramientas nativas que proporciona Azure, así como implementar políticas de reintento y manejo inteligente de errores que permitan adaptarse a condiciones de inestabilidad temporal. También se aconseja optimizar las solicitudes enviadas al servicio, definiendo con precisión los prompts y limitando la cantidad de tokens para evitar sobrecargas innecesarias.

Este enfoque contribuye a reducir la latencia y mejora la eficiencia general. Adicionalmente, realizar pruebas de carga y simulaciones en entornos controlados ayuda a detectar posibles cuellos de botella y ajustar configuraciones antes de desplegar aplicaciones en producción. Es relevante que los desarrolladores mantengan una comunicación activa con el soporte de Azure para reportar incidencias, acceder a actualizaciones y recibir asesoría técnica específica que atienda sus particularidades. La colaboración entre usuarios puede asimismo facilitar la identificación de patrones comunes, lo que genera más presión para que el servicio tome medidas rápidas y efectivas. La escalabilidad de los recursos ofrecidos por Azure es clave para que modelos como GPT-4 funcionen sin contratiempos en escenarios críticos.

Sin embargo, la infraestructura no es infalible y puede presentar limitaciones momentáneas. Frente a esto, algunas alternativas incluyen implementar soluciones híbridas que combinan procesamiento local con llamadas a la nube o explorar arquitecturas basadas en microservicios que permitan distribuir la carga y aislar las funciones más susceptibles a fallos. Otra área a considerar es la seguridad. Los mecanismos de autenticación y autorización deben estar configurados correctamente para evitar rechazos inesperados que a veces se traducen en fallos o latencias elevadas. Mantener actualizado el SDK y las dependencias garantiza compatibilidad con las últimas mejoras y parches de rendimiento, lo cual influye directamente en la calidad del servicio.

En conclusión, aunque Azure OpenAI continúa posicionándose como una de las plataformas más prometedoras para integrar inteligencia artificial generativa en proyectos modernos, los problemas de latencia y disponibilidad reportados representan un llamado a la prudencia en su implementación. Los usuarios deben informarse continuamente, aplicar estrategias de optimización y mantener una actitud proactiva en la gestión y diagnóstico de incidentes. La inteligencia artificial tiene un potencial inmenso, pero su adopción exitosa pasa por entender y superar las barreras técnicas que surgen en etapas de maduración tecnológica. Adoptar enfoques resilientes y contar con un soporte adecuado permitirá sacar el máximo provecho a estas herramientas vanguardistas sin sacrificar la experiencia del usuario final.