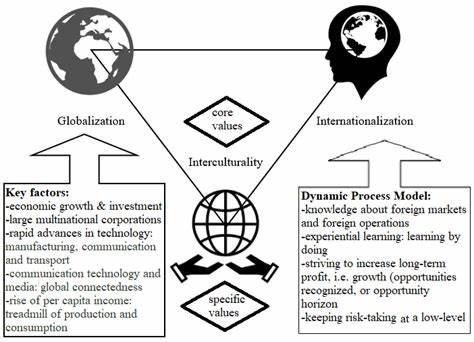

En la era digital actual, la información está ampliamente disponible en páginas web, pero gran parte de este contenido se encuentra en formato HTML, diseñado para ser leído por humanos más que por máquinas. Para aprovechar al máximo esta abundancia de datos, especialmente en contextos donde se usan técnicas avanzadas de inteligencia artificial, es fundamental convertir dicho contenido en formatos estructurados, como JSON. Esta transformación es especialmente relevante para los sistemas de Recuperación Augmentada por Generación (RAG), que combinan la recuperación de información con modelos generativos para ofrecer respuestas precisas y contextuales. El proceso de extraer y estructurar contenido HTML en JSON representa un paso crucial hacia una mayor eficiencia en la gestión de la información. Actualmente, muchas aplicaciones y flujos de trabajo necesitan datos limpios, organizados y fácilmente interpretables por máquinas para funcionar correctamente.

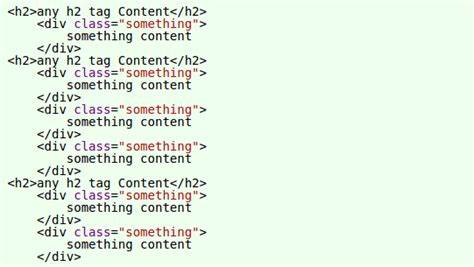

Por ejemplo, asistentes virtuales, chatbots, motores de búsqueda internos y herramientas analíticas dependen en gran medida de la calidad del contenido estructurado. Al convertir páginas web en JSON, se puede transformar la información desordenada en una representación accesible que alimenta algoritmos con datos relevantes y comprensibles. Para lograr este objetivo, se deben considerar varios aspectos técnicos. Primero, es necesario identificar y extraer los elementos importantes dentro del HTML, como títulos, párrafos, imágenes, tablas y enlaces. Esto puede realizarse mediante técnicas de web scraping utilizando bibliotecas especializadas que permiten navegar por la estructura del documento y capturar la información clave.

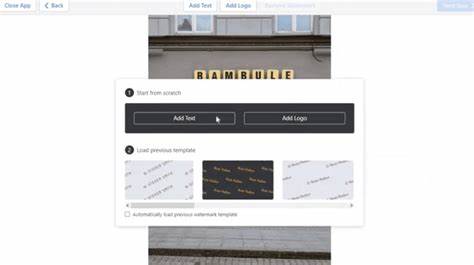

A continuación, se realiza una limpieza y normalización del contenido para asegurar que los datos sean coherentes y apropiados para la visualización o procesamiento posterior. Un POC (prueba de concepto) que demuestre esta capacidad suele incluir una interfaz donde el usuario ingresa la URL deseada para extraer la información. Detrás del escenario, un motor basado en inteligencia artificial o un algoritmo específico analiza el HTML, purga el ruido, selecciona el contenido más relevante y lo convierte en una estructura JSON legible y bien organizada. Este resultado puede incluir metadatos adicionales, como etiquetas, fechas, autores y más, enriqueciendo aún más la calidad de los datos. Los beneficios de estructurar el contenido en JSON para RAG son múltiples.

En primer lugar, permite que los modelos generativos trabajen con información más precisa y específica, mejorando la calidad de las respuestas y reduciendo errores o ambigüedades. Además, facilita el almacenamiento y la consulta eficiente en bases de datos, posibilitando integraciones sencillas con otras aplicaciones o servicios. La reutilización de datos se potencia, asegurando que la información recopilada tenga un ciclo de vida más largo y una utilidad mayor. En el campo del procesamiento del lenguaje natural y la inteligencia artificial, una estructura de datos adecuada es la base para que los sistemas aprendan, generen contenido y respondan consultas complejas. Cuando el contenido web es caótico o carece de un formato uniforme, los modelos tienen dificultades para entender el contexto o extraer insight relevantes.

Por ello, contar con un JSON bien construido desde el HTML original no solo mejora la precisión, sino que también acelera el entrenamiento y la inferencia de los modelos. Implementar estas soluciones puede resultar desafiante debido a la diversidad en el diseño de páginas web, la variedad de estructuras HTML y las limitaciones de acceso o anti-scraping implementadas en algunos sitios. Sin embargo, con técnicas actuales de scraping inteligente y aprendizaje automático, es posible superar muchas barreras y automatizar gran parte del proceso. Este avance contribuye a democratizar el acceso a datos de calidad, expandiendo las posibilidades para empresas y desarrolladores que buscan integrar inteligencia artificial en sus productos. En conclusión, convertir contenido web en JSON estructurado es una práctica esencial para potenciar los sistemas de RAG y otras tecnologías basadas en IA.

Esta transformación no solo mejora la calidad de la información capturada, sino que también promueve flujos de trabajo más ágiles y eficientes, adaptados a las necesidades actuales del mercado digital. A medida que las herramientas y técnicas evolucionan, la automatización de este proceso se volverá cada vez más accesible, permitiendo un acceso más inteligente y efectivo a la vasta cantidad de datos ofrecidos por la web.