En la era digital actual, vivimos rodeados de dispositivos cada vez más poderosos. Los procesadores tienen núcleos múltiples, la memoria RAM se mide en gigabytes y los discos sólidos superan en velocidad a cualquier disco duro tradicional. Sin embargo, muchos usuarios han notado una inquietante realidad: pese a contar con esta tecnología avanzada, la interacción diaria con los ordenadores modernos puede sentirse notoriamente lenta y poco responsiva. Este fenómeno, que a simple vista parece una contradicción, ha sido recientemente analizado por Julio Merino, un especialista en sistemas y desarrollo de software, quien ha comparado la experiencia de usuario entre máquinas antiguas y modernas, revelando datos sorprendentes. Merino expuso a través de vídeos cómo un equipo de hace más de veinte años, con recursos que hoy consideraríamos limitados —un procesador AMD K7 a 600MHz, 128MB de RAM y un disco duro mecánico a 5400 RPM— podía ejecutar tareas básicas como abrir aplicaciones de sistema con una velocidad y fluidez muy por encima de dispositivos actuales con Windows 11, incluyendo máquinas relativamente modernas como una Surface Go 2 o un Mac Pro del 2013 con procesadores mucho más potentes y amplias capacidades de RAM y almacenamiento solid-state.

¿Cómo es posible que dispositivos de más capacidad y mejor hardware parezcan más lentos en operaciones básicas? Para entender este fenómeno, es necesario analizar varios factores que han influido en la evolución del software y cómo éste utiliza el hardware disponible. En primer lugar, la comparativa directa entre ordenadores con sistemas operativos y aplicaciones diseñadas para épocas muy distintas nunca será perfecta, aunque, como Merino señala, incluso comparaciones más equilibradas reproducen este fenómeno de latencia elevada en máquinas más modernas. En esencia, la interfaz y la experiencia de usuario se han vuelto mucho más complejas y, en muchos casos, pesadas en términos de recursos consumidos. El sistema operativo de hace 20 años era excepcionalmente ágil en la gestión de procesos simples, con una interfaz limpia y minimalista. Windows 2000, por ejemplo, mostraba una respuesta inmediata al abrir aplicaciones, y a pesar de no contar con las bondades gráficas actuales, lograba una experiencia muy fluida.

Por el contrario, los sistemas actuales, como Windows 11, macOS recientes o incluso Linux con entornos modernos de escritorio, integran capas adicionales de abstracción, efectos visuales, animaciones, y compatibilidad con un enorme rango de hardware y software, lo que inevitablemente añade una carga. Aunque muchos argumentan que la culpa es de la mayor resolución de pantalla o de las animaciones, Merino demuestra que desactivar estos efectos no elimina el retraso notable al abrir aplicaciones. Un punto clave que impacta negativamente la rapidez percibida es cómo las aplicaciones modernas están siendo diseñadas y construidas. La adopción masiva de frameworks como Electron, que permite crear aplicaciones multiplataforma usando tecnologías web, ha facilitado a las empresas reducir costos de desarrollo y mantener una base de código única. Sin embargo, esta conveniencia tiene un precio.

Aplicaciones que antes eran nativas y ligeras, como Spotify o 1Password, hoy consumen recursos considerablemente mayores y tardan más en responder. La decisión de depender de tecnologías web dentro de aplicaciones de escritorio impone una penalización continua en términos de eficiencia y rapidez. Sumado a esto, el uso de lenguajes interpretados o gestionados como Java o C# puede añadir tiempos de arranque y latencias superiores, ya que inicialmente el entorno de ejecución debe compilar o preparar el código para su ejecución. Aunque estas tecnologías han evolucionado para optimizar la ejecución a largo plazo, el tiempo que tardan en iniciar rápidas tareas o aplicaciones pequeñas sigue siendo un reto. Esto contrasta con los lenguajes compilados más tradicionales, que generan código nativo listo para ejecutarse al instante sin interpretes ni máquinas virtuales intermedias.

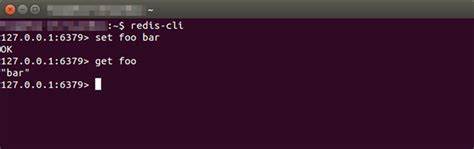

Merino también destaca que la mejora más importante en rendimiento y rapidez de respuesta en los últimos años fue la irrupción de las unidades de estado sólido (SSD). Estas tecnologías revolucionaron los tiempos de lectura y escritura, especialmente en operaciones de acceso aleatorio, que antes eran un cuello de botella fundamental en discos duros mecánicos. No obstante, esa mejora fue un cambio único en la industria y es difícil que futuras tecnologías ofrezcan incrementos similares de impacto. Lamentablemente, el avance logrado con los SSDs está siendo erosionado por el creciente peso del software y las malas decisiones en diseño, que consumen cada vez más recursos sin mejorar realmente la experiencia del usuario. Este círculo vicioso genera que la potencia bruta del hardware crezca, pero la velocidad para tareas cotidianas, como abrir una aplicación simple o movernos entre ventanas, se estanque o incluso se degrade.

El resultado es una sensación generalizada de que los equipos modernos no son más rápidos que los antiguos, y a menudo lo son menos en esas interacciones básicas. Esto tiene un impacto directo en la productividad o en el disfrute del sistema, y ultimadamente puede desembocar en frustración y la necesidad de invertir en hardware más potente para paliar la deficiencia de software. En un extremo opuesto, se puede tomar como ejemplo a Linux, que parece mantener una buena respuesta incluso en hardware modesto, debido a que sus desarrolladores prestan más atención a la eficiencia. Sin embargo, esto no significa que esté exento de problemas, pues una vez que los usuarios empiezan a utilizar aplicaciones modernas multiplataforma, esos problemas de latencia y lentitud aparecen casi de inmediato. Así, no es un problema exclusivo de Windows o macOS sino que afecta a todo el ecosistema informático actual.

Otro aspecto a considerar es cómo cambian las prioridades en el desarrollo de software. Hoy en día, la velocidad de desarrollo y la reducción de costes son más importantes para muchas empresas que la optimización de rendimiento. Frameworks modernos, bibliotecas, capas de abstracción y todo tipo de dependencias hacen que una aplicación básica sea en realidad un conjunto enorme e interdependiente de componentes. Esto ayuda a acelerar la fase de creación pero conlleva la penalización constante en el producto final: software pesado, lento y hogareño con recursos. También se ha señalado que la evolución hacia interfaces más gráficas, con cuidados estéticos, animaciones y un sistema operativo que incluye muchas funciones integradas, hace que las expectativas sean más exigentes, aunque el peso de esos elementos gráficos no puede ser el único culpable del problema, según las pruebas presentadas.

Julio Merino advierte en su análisis que, a menos que los arquitectos de hardware y software prioricen revertir esas tendencias, las mejoras en rendimiento reactivo seguirán estancándose o empeorando, y recuerda que confiar en una nueva revolución tecnológica para salvar esta situación podría ser arriesgado. El camino correcto debería pasar por hacer software ligero, eficiente y no sacrificar la experiencia del usuario en tareas básicas a cambio de agregar capas de complejidad innecesarias. En conclusión, el contraste entre máquinas antiguas y modernas pone de manifiesto una problemática vigente en la informática actual: el equilibrio entre potencia, características y velocidad de respuesta está roto. La promesa de máquinas siempre más veloces no se cumple en la práctica diaria debido a decisiones del ecosistema de software. Para recuperar la fluidez y satisfacción del usuario en la interacción cotidiana, es crucial que desarrolladores, fabricantes y usuarios tomen consciencia de que más potencia no sustituye el buen diseño y la optimización inteligente.

Solo así se podrán disfrutar los avances tecnológicos sin sacrificar la sensación de rapidez y eficiencia que esperábamos hace dos décadas.