En el dinámico mundo de la inteligencia artificial, la velocidad y eficiencia en la inferencia de modelos son factores cruciales que pueden determinar el éxito o fracaso de una aplicación. Reconociendo esta necesidad, Meta ha establecido una colaboración estratégica con Cerebras, una empresa especializada en hardware y soluciones de computación acelerada, para lanzar una revolucionaria API que integra los modelos Llama con la tecnología de inferencia más rápida del mundo. Esta alianza representa un cambio de paradigma en el desarrollo de aplicaciones de inteligencia artificial, especialmente aquellas que requieren procesamiento en tiempo real y baja latencia. Meta es conocido globalmente por sus innovaciones en inteligencia artificial y su enfoque en democratizar el acceso a herramientas avanzadas para desarrolladores. Por su parte, Cerebras se ha destacado desde 2024 por ofrecer los sistemas más veloces para ejecución de inferencias de modelos complejos, gracias a su sistema CS-3 y su procesador Wafer-Scale Engine-3, que son pioneros en la arquitectura de supercomputadoras para IA.

La combinación de la experiencia de ambas compañías da lugar a una plataforma sin precedentes que potencia el rendimiento de modelos como Llama 4, permitiendo acelerar la generación de resultados hasta 18 veces más rápido que las tecnologías clásicas basadas en GPU. Uno de los principales beneficios de esta nueva API es la capacidad que ofrece a los desarrolladores para crear aplicaciones que antes parecían inviables debido a limitaciones técnicas o de tiempo de respuesta. Entre las aplicaciones que se podrán desarrollar destacan aquellas con capacidades de voz conversacional de baja latencia, generación interactiva de código, razonamiento en múltiples pasos y agentes inteligentes en tiempo real. Todas estas aplicaciones requieren encadenar múltiples llamadas a modelos de lenguaje grande (LLM), un proceso que tradicionalmente ralentizaba la interacción y hacía difícil el desarrollo fluido. Gracias a la velocidad y escalabilidad de la tecnología de Cerebras integrada en la API de Llama, dichos procesos se realizan en segundos en lugar de minutos, mejorando de manera exponencial la experiencia de usuario final y la eficiencia operativa.

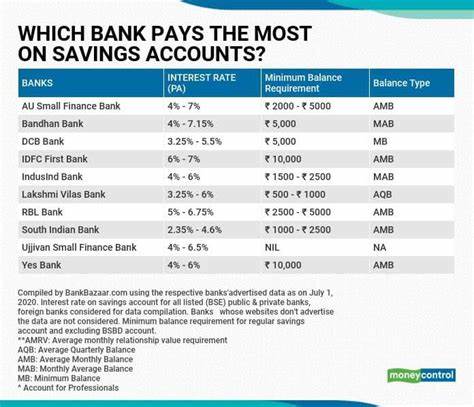

La relevancia de este avance también radica en el acceso ampliado para la comunidad global de desarrolladores. La API de Llama, al incorporar las soluciones de inferencia de Cerebras, ofrece una alternativa robusta y competitiva respecto a otras ofertas de mercado, incluso comparadas con gigantes como OpenAI. Según datos independientes, Cerebras ha alcanzado una tasa de procesamiento superior a 2,600 tokens por segundo en modelos Llama 4 Scout, mientras que soluciones populares como ChatGPT alcanzan aproximadamente 130 tokens por segundo. Esta diferencia cuantitativa refleja la capacidad de Cerebras para soportar cargas de trabajo exigentes, permitiendo a los desarrolladores crear sistemas de inteligencia artificial ágil y escalables de manera sencilla. Para los desarrolladores interesados, el acceso a esta API se facilita a través de la selección directa de Cerebras entre las opciones de modelos disponibles en la interfaz de Llama API.

Esto no solo agiliza el proceso de prototipado, sino que también permite la rápida implementación y escalabilidad de nuevas aplicaciones, facilitando así la innovación continua. Adicionalmente, el compromiso de Meta y Cerebras para mantener abierta esta plataforma con soporte a modelos de código abierto garantiza un ecosistema saludable y colaborativo que invita a la experimentación y mejora constante. Las implicaciones para sectores como atención al cliente, desarrollo de software, automatización empresarial, educación y muchas otras industrias son profundas. La capacidad para integrar agentes conversacionales inteligentes que respondan prácticamente en tiempo real puede transformar la manera en que se interactúa con la tecnología, reduciendo la brecha entre inteligencia artificial y usuarios comunes. Empresas que busquen diferenciarse podrán construir productos con funcionalidades avanzadas antes inaccesibles debido a las barreras de latencia y velocidad.

Cerebras como compañía emerge como un actor clave en este escenario, ofreciendo no solo hardware avanzado sino también soluciones de nube y onsite que permiten a clientes corporativos y académicos beneficiarse de la potencia de sus supercomputadoras de IA. El arquitecto principal y CEO de Cerebras, Andrew Feldman, ha expresado con entusiasmo la potencialidad de esta colaboración y el impacto que tendrá para los desarrolladores, enfatizando la necesidad de velocidad en la creación de aplicaciones con requerimientos elevados y tiempos de respuesta inminentes. En definitiva, la colaboración entre Meta y Cerebras y el lanzamiento de la nueva API Llama con integración de tecnología Cerebras no solo demuestran el avance tecnológico en la industria de la inteligencia artificial, sino que también abren un nuevo capítulo en la forma en que se diseñan y ejecutan aplicaciones inteligentes. Los desarrolladores ahora cuentan con una herramienta poderosa para superar desafíos previos, acelerar la innovación y ofrecer experiencias únicas a los usuarios. Para acceder a esta innovadora API y aprovechar las ventajas que ofrece Cerebras en la aceleración de la inferencia de modelos de lenguaje, los interesados pueden registrarse a través del portal oficial de Cerebras.

Esta oportunidad representa un punto de inflexión para el sector tecnológico y una invitación abierta para quienes buscan liderar la próxima generación de aplicaciones basadas en inteligencia artificial. En resumen, la sinergia entre Meta y Cerebras posiciona a la nueva API Llama como una plataforma líder en velocidad y capacidad, impulsando la expansión del ecosistema de inteligencia artificial con opciones más rápidas, eficientes y accesibles para desarrolladores alrededor del mundo. El futuro de las aplicaciones de IA en tiempo real nunca ha sido tan prometedor.