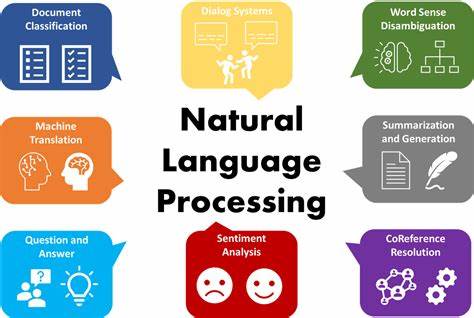

El campo del procesamiento del lenguaje natural (PLN) ha experimentado una revolución significativa con la incorporación del aprendizaje profundo. Este cambio no se basa en soluciones mágicas ni en trucos complejos, sino en el entendimiento profundo de cómo las máquinas pueden aprender a interpretar el lenguaje humano mediante datos. Desde 2013, destacados investigadores como Richard Socher y Christopher Manning han sentado las bases para explicar y popularizar estos métodos, acercándolos a la comunidad con un enfoque didáctico y transparente. En esencia, el aprendizaje profundo en el PLN se aleja del paradigma clásico que depende fuertemente de características diseñadas manualmente por expertos. Tradicionalmente, para llevar a cabo tareas como etiquetado de partes de la oración, reconocimiento de entidades nombradas o análisis de sentimientos, los científicos tenían que crear y ajustar cuidadosamente conjuntos de reglas y representaciones numéricas basadas en su conocimiento lingüístico.

Este proceso, además de ser laborioso, limitaba la escalabilidad y la adaptabilidad de los modelos. Los métodos de aprendizaje profundo buscan que las propias máquinas aprendan directamente de los datos relevantes, construyendo representaciones internas que capturan de manera eficiente y discriminativa los aspectos relevantes del lenguaje. Esta capacidad representa un cambio paradigmático que ha demostrado mejoras notables en múltiples tareas del PLN contemporáneo, incluyendo modelado de lenguaje, análisis semántico y detección de parafraseo. Una de las claves para entender el aprendizaje profundo aplicado al lenguaje radica en las redes neuronales y su capacidad para modelar funciones complejas mediante múltiples capas de unidades computacionales interconectadas. En la base de esta técnica, se encuentran los llamados vectores de palabras o word embeddings, que representan cada término como un vector numérico en un espacio multidimensional, capturando relaciones semánticas y sintácticas de forma implícita.

Estos vectores surgen generalmente de métodos de aprendizaje no supervisados que aprovechan grandes cantidades de texto sin etiquetar. De esta forma, el aprendizaje se sustenta en la co-ocurrencia de palabras y patrones contextuales, lo que posibilita que las máquinas descubran similitudes y conexiones que no requieren intervención humana directa. Así, una palabra como "rey" se ubicará cerca de términos relacionados como "reina" o "monarca" en el espacio vectorial generado. El entrenamiento de estos modelos se realiza mediante algoritmos numéricos optimizados, cuyo corazón es el método de retropropagación del error (backpropagation), que ajusta los pesos de las conexiones neuronales para minimizar la diferencia entre las predicciones y los resultados esperados. En las etapas iniciales, el tutorial impartido por Socher y Manning presenta ejemplos simples basados en ventanas locales de texto, facilitando la comprensión gradual antes de abordar estructuras más complejas.

Lo más innovador dentro del aprendizaje profundo para PLN son las redes neuronales recurrentes y las redes neuronales recursivas, que permiten modelar dependencias a largo plazo y analizar estructuras jerárquicas del lenguaje, respectivamente. Mientras las primeras son capaces de procesar texto de forma secuencial, manteniendo un estado que captura información previa, las segundas trabajan con árboles sintácticos y estructuras parseadas, facilitando la comprensión del significado de frases y oraciones en su conjunto. El uso de redes neuronales recursivas ha sido particularmente transformador para tareas que requieren análisis composicional, como la detección de parafraseo y el análisis de sentimiento. Estas redes pueden aprender representaciones vectoriales para frases completas, al combinar sistemáticamente los vectores de palabras y subfrases de acuerdo con la estructura gramatical. Esto permite que el modelo no sólo entienda el significado de palabras individuales, sino también cómo estas interactúan en contextos complejos.

Además, las variantes más sofisticadas de estas arquitecturas, como las redes neuronales tensoriales recursivas y los autoencoders recursivos, han ampliado las posibilidades para capturar interacciones no lineales y relaciones semánticas profundas, incrementando así la precisión en la clasificación de emociones, reconocimiento de relaciones y análisis sintáctico. Por otro lado, la flexibilidad y eficiencia de estos métodos hacen posible su adopción sin la necesidad de recursos externos costosos ni de intensiva ingeniería manual de características. Esto democratiza el acceso a herramientas poderosas para el PLN, permitiendo a investigadores y desarrolladores crear sistemas capaces de aprender de manera autónoma a partir de los datos. Sin embargo, el aprendizaje profundo en el PLN no está exento de desafíos. La optimización de estos modelos puede ser compleja y susceptible a problemas como el sobreajuste, lo que exige el empleo de técnicas adicionales como la regularización, el ajuste cuidadoso de hiperparámetros y el uso de conjuntos amplios y diversos de datos para el entrenamiento.

El tutorial de 2013 enfatiza la importancia de entender y aplicar estos trucos y estrategias para maximizar el rendimiento. En el panorama actual, el aprendizaje profundo ha dado lugar a una amplia gama de modelos y aplicaciones, incluyendo modelos de bolsa de palabras mejorados, redes neuronales convolucionales aplicadas a la NLP, y los famosos transformadores que posteriormente revolucionaron la generación y comprensión de lenguaje natural. La base sentada por Socher y Manning a través de su presentación clara y didáctica sigue siendo fundamental para quienes busquen comprender las raíces y las ideas esenciales detrás de estas técnicas. Finalmente, para profundizar en el aprendizaje profundo aplicado al PLN, existen múltiples recursos que permiten desde la implementación práctica hasta la exploración teórica. Entre estos, destaca un ejercicio desarrollado para la clase cs224N de Stanford que guía a los estudiantes a implementar un etiquetador de entidades nombradas basado en ventanas, contribuyendo a consolidar la comprensión de los conceptos mediante la práctica.

Asimismo, tutoriales y códigos abiertos facilitados en ese contexto enriquecen el aprendizaje autónomo. En conclusión, el aprendizaje profundo para el procesamiento del lenguaje natural representa una evolución significativa en la manera en que las máquinas entienden y procesan el lenguaje humano. Al poner fin a la era de las soluciones basadas en ingeniería manual, ofrece herramientas poderosas que aprovechan la riqueza de datos disponibles para construir modelos efectivos y flexibles. De este modo, se evita la apariencia de "magia negra" y se promueve una comprensión transparente, intuitiva y científica, esencial para avanzar en la inteligencia artificial lingüística.

![Caoimhín Ó'Raghallaigh demonstrates how the Hardanger d'amore works [video]](/images/3F78E818-9224-42BC-97B3-7F3B783031C1)