En el mundo vertiginoso y en constante evolución de la inteligencia artificial, especialmente en el ámbito de los modelos de lenguaje, ha surgido una práctica que está ganando cada vez más protagonismo: los 'vibe checks'. Aunque podría parecer un término coloquial, en la actualidad los especialistas y usuarios adoptan cada vez más esta metodología intuitiva para evaluar la efectividad y funcionalidad de los modelos de lenguaje de inteligencia artificial, dejando de lado, al menos en el día a día, las evaluaciones estrictamente cuantitativas. Esta tendencia se basa en una idea simple pero poderosa: la intuición y la experiencia práctica ofrecen una perspectiva rápida, útil y suficientemente precisa para determinar si un modelo cumple con las expectativas de su usuario o desarrollador. Tradicionalmente, en la ciencia y la ingeniería se ha privilegiado el rigor, los indicadores clave de rendimiento (KPIs), las métricas definidas y la realización de análisis exhaustivos para validar cualquier producto o avance tecnológico. Sin embargo, en el contexto actual de la inteligencia artificial generativa, esta formalidad se complementa y, en ocasiones, se ve reemplazada en la práctica diaria por evaluaciones de tipo cualitativo y sensitivo.

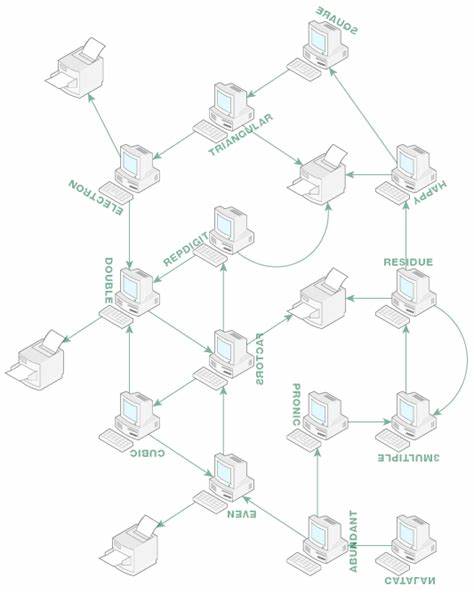

Hay que entender que el auge de la inteligencia artificial generativa ha democratizado el acceso y uso de tecnologías complejas. Hoy en día, cualquier desarrollador de software o usuario avanzado puede interactuar con potentes modelos sin necesidad de ser un experto profundo en estadística bayesiana, métricas formales de clasificación o en el diseño complejo de funciones de pérdida y ajuste de hiperparámetros. A través de técnicas como el 'prompting', la construcción de contextos y la sutil personalización del modelo, resulta posible obtener resultados sorprendentes en breves iteraciones. En este escenario, el 'vibe check' se convierte en una herramienta esencial para juzgar rápidamente si el modelo es útil, fiable o apropiado para las tareas que se le asignan. Esta práctica no es completamente nueva ni exclusiva de la inteligencia artificial.

Históricamente, en diversos campos de la tecnología y el aprendizaje automático, se han usado métodos informales basados en sensaciones, opiniones o pruebas visuales como filtros iniciales para identificar problemas o confirmar avances. Desde filtrar spam mediante evaluaciones subjetivas hasta comprobar la seguridad en sistemas autónomos con simples tests de apariencia o intuición, estas técnicas han acompañado el desarrollo tecnológico durante años. El valor del 'vibe check' radica en su rapidez y eficiencia, especialmente cuando se necesita realizar múltiples evaluaciones cotidianas que no justifican un análisis profundo o formal. La gran mayoría de los desarrolladores de inteligencia artificial reconocen este enfoque aunque pocas veces lo admiten públicamente debido a la falta de la rigurosidad asociada con métodos estadísticos. No obstante, la realidad indica que casi el 99% de las evaluaciones realizadas en el uso habitual de los modelos de lenguaje califican exitosamente mediante una especie de prueba intuitiva o de sensación.

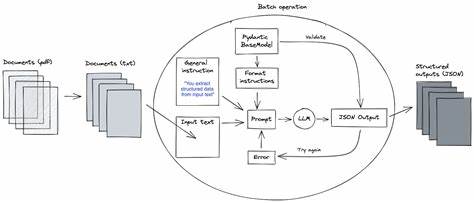

Por otro lado, las evaluaciones cuantitativas y formales siguen siendo vitales para los extremos del desarrollo tecnológico, es decir, aquellas instancias donde se requieren pruebas precisas, reproducibles y escalables, como sucede en la publicación científica, el control de calidad a gran escala y los procesos de automatización y regresión. Estas evaluaciones rigurosas funcionan como termómetros científicos que permiten comparar modelos con alta precisión, establecer rankings y determinar claramente líderes del sector. Sin embargo, estas son excepciones dentro de la rutina diaria del desarrollo y uso de la inteligencia artificial. Un aspecto interesante que acompaña esta dinámica es que, a medida que el usuario se habitúa a un modelo específico, comienza a establecer una relación de confianza y entendimiento con él, similar a la interacción interpersonal en ambientes laborales o sociales. Esta familiaridad genera una percepción madura y sólida sobre las fortalezas, limitaciones y comportamientos de cada sistema, lo que facilita la aprobación o el rechazo basado en mayor experiencia y sensación personal, más allá de los números o pruebas formales.

Este fenómeno también introduce un desafío: la dificultad para evaluar a fondo varios modelos si se requiere ese período de adaptación y aprendizaje mutuo. Solo con tiempo y uso continuado se puede obtener una imagen clara y completa de las capacidades y defectos de un modelo. Por ello, la comunidad trabaja para crear sistemas de evaluación que integren los puntos fuertes de los métodos formales con la agilidad de los 'vibe checks', buscando transformar estas sensaciones en benchmarks cuantificables que puedan ser compartidos y replicables. En redes sociales y foros especializados, la discusión sobre la calidad de modelos como GPT-4 refleja este punto. Los usuarios debaten si ciertas actualizaciones han mermado la creatividad o la habilidad para generar código, lo que muestra cómo la percepción subjetiva basada en experiencias diarias puede diferir de las evaluaciones técnicas oficiales.

Este sentido común colectivo y el intercambio sobre el rendimiento real de las inteligencias artificiales afectan la reputación y la evolución de estas tecnologías. Expertos del sector, como Andrej Karpathy, llaman la atención sobre la complejidad e importancia de desarrollar evaluaciones eficaces. En sus experiencias, dedicar una proporción significativa de tiempo a la recopilación de datos y la creación de evaluaciones rigurosas es esencial para que los resultados cuantitativos y cualitativos puedan alinearse y ofrecer un diagnóstico certero de un modelo. Sin embargo, reconoce que esta labor es cara y ardua, por lo que las soluciones perfectas aún parecen lejanas, dejando espacio para que los desarrolladores acepten el uso del 'vibe check' sin remordimientos. Esta evolución en las metodologías de evaluación también refleja un cambio cultural impulsado por la expansión masiva de la inteligencia artificial generativa.

Al convertir a una gran cantidad de profesionales de software en usuarios y creadores de modelos de machine learning, la técnica ya no se limita a un grupo pequeño y especializado, sino que se extiende como una práctica cotidiana accesible. Esto facilita la innovación, la personalización rápida y el ajuste intuitivo, aspectos que se nutren enormemente del juicio subjetivo y la interacción continua más que del análisis estadístico frío. En síntesis, aunque el camino hacia la perfección en la evaluación de modelos de lenguaje continúa siendo largo y requerirá esfuerzos colaborativos para crear estándares uniformes y precisos, los 'vibe checks' se han consolidado como un recurso válido y efectivo. Representan la percepción humana aplicada en la interacción directa con tecnologías cada vez más inteligentes y complejas, logrando resultados prácticos que rara vez decepcionan. En definitiva, abrazar estas sensaciones, respaldarlas con observación constante y combinarlas con las herramientas formales disponibles permitirá a desarrolladores y usuarios sacar el máximo provecho de la inteligencia artificial generativa.

Reconocer el valor del instinto y la experiencia cotidiana en la evaluación tecnológica no solo es prudente, sino esencial para navegar el futuro de la interacción hombre-máquina con éxito y confianza.