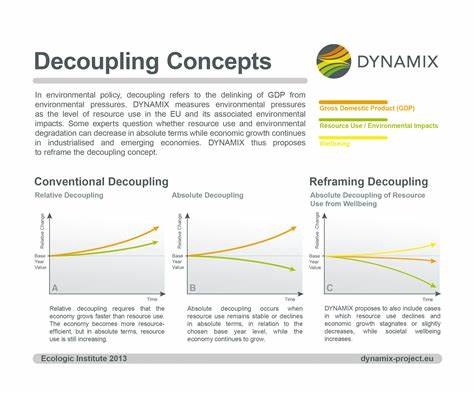

El entorno tecnológico actual está en constante evolución y, con cada avance, se reafirman ciertos principios fundamentales que guían a los desarrolladores y arquitectos de sistemas hacia soluciones más robustas y sostenibles. Entre esos principios, uno de los más esenciales y perdurables es el desacoplamiento. Este concepto, aunque simple en su esencia, tiene implicaciones profundas para el desarrollo de software, la construcción de infraestructura en la nube y el diseño de arquitecturas escalables. Comprender el desacoplamiento y sus beneficios es fundamental para quienes buscan crear sistemas que no solo funcionen bien hoy, sino que evolucionen eficientemente mañana. El desacoplamiento se refiere a la práctica de diseñar componentes o módulos de un sistema de tal manera que estén independizados unos de otros en la medida de lo posible.

Esto significa que un cambio o problema en un componente no debería afectar directamente a los demás. La historia del desacoplamiento en la ingeniería del software se remonta a décadas atrás, a trabajos pioneros como el publicado en 1972 por D.L. Parnas, que explicaba la importancia del ocultamiento de información dentro de módulos para lograr sistemas más manejables y fáciles de mantener. Parnas ilustraba que al ocultar detalles internos, como el modo de almacenamiento de datos, dentro de un módulo, cualquier cambio dentro de dicho módulo no requeriría modificaciones en otros módulos.

Este enfoque, que promueve que los cambios solo influyan en un área limitada, ha sido un pilar en el diseño modular de sistemas desde entonces. No sólo facilita la escalabilidad y el mantenimiento, sino que también reduce la complejidad y los errores durante la evolución del software. Un ejemplo palpable y actual que sigue esta filosofía es el estándar POSIX, que desacopla las aplicaciones del sistema operativo subyacente. Gracias a POSIX, un programa puede ejecutarse en diferentes sistemas operativos sin necesidad de reescribirlo, lo que otorga flexibilidad y amplia portabilidad. De forma similar, el lenguaje C es otro ejemplo de desacoplamiento exitoso, ya que permite que el mismo código fuente se compile y funcione en múltiples plataformas mediante diferentes compiladores específicos.

Además, las características modernas en lenguajes como las generics, que permiten desacoplar los tipos de datos de los algoritmos, amplifican la capacidad de reutilización y de creación de códigos más seguros y eficientes. A través del desacoplamiento, también pueden diseñarse sistemas de almacenamiento flexible como ZFS, que separa la infraestructura física del almacenamiento de cómo se gestiona y particiona, eliminando la preocupación de decisiones rígidas y permitiendo una administración más eficiente de los recursos. En el contexto del almacenamiento y la computación en la nube, el desacoplamiento adquiere una dimensión aún más relevante. Tecnologías y protocolos como NFS, SMB, iSCSI y servicios de almacenamiento en la nube como Amazon EBS ejemplifican cómo separar el almacenamiento de los recursos computacionales potencia una administración más efectiva, mejor escalabilidad y mayor resiliencia. Esta división se refleja también en el uso común de redes inalámbricas, donde el lugar físico no limita el acceso a recursos conectados, permitiendo actividades como trabajar desde cualquier lugar del mundo sin mayor infraestructura física.

El éxito del desacoplamiento también está reflejado en la filosofía Unix, que promueve la creación de pequeñas herramientas especializadas y desacopladas capaces de interactuar entre sí, fomentando la flexibilidad y la innovación en el desarrollo de software y sistemas. Sin embargo, no todo es desacoplamiento sin punto medio. Algunos productos y tecnologías recientes han intentado fusionar el código de infraestructura con el código de aplicación, como es el caso de Winglang. Este lenguaje propone combinar ambas capas para simplificar el desarrollo, pero tal acoplamiento crea consecuencias que deben ser evaluadas cuidadosamente. Al acoplar infraestructura y aplicación en un solo lenguaje o entorno, se limita la capacidad de evolución y adaptación a largo plazo.

Por ejemplo, puede ocurrir un bloqueo tecnológico, donde la dependencia de una API, lenguaje o proveedor se convierte en un freno para la innovación o la migración a otros sistemas. Las preguntas que surgen al evaluar soluciones acopladas incluyen si el lenguaje permite controlar todos los parámetros necesarios, si su potencia y flexibilidad son suficientes, o si se puede cambiar a otro proveedor cloud sin tener que rehacer la aplicación completa. Estas preocupaciones son válidas y justifican el prestigio por el desacoplamiento. Por el contrario, mantener el código de infraestructura separado del código de aplicación permite elegir herramientas específicas para cada parte, facilita la migración y reduce las dependencias. El desacoplamiento también aporta una mayor opcionalidad, entendida como la capacidad de elegir entre diferentes soluciones tecnológicas según las necesidades o cambios futuros.

Al no tener las piezas rígidamente enlazadas, se puede adaptar el sistema a nuevos proveedores, arquitecturas o requerimientos sin rehacerlo desde cero. Esto es fundamental en un mundo tecnológico caracterizado por su rápida evolución y diversidad de opciones. Por supuesto, hay casos donde cierto grado de acoplamiento es inevitable o incluso beneficioso, particularmente cuando el beneficio supera los costos asociados. Un ejemplo clásico es el uso de AWS S3 para almacenamiento de objetos; su API especializada requiere que las aplicaciones estén diseñadas para acceder a ella, pero la capacidad de tener un almacenamiento escalable y accesible globalmente justifica ampliamente esa especialización. La popularidad de S3 ha llevado a que muchos proveedores emulen su API, creando un ecosistema más flexible que, a final de cuentas, vuelve a potenciar el desacoplamiento al permitir intercambiar almacenamiento sin cambiar la lógica de aplicación.

Este fenómeno ilustra otro reto estimulante: la idea de construir plataformas multi-cloud totalmente abstractas que unifiquen todos los proveedores bajo una sola capa ha probado ser compleja, ya que el grado de personalización y características propias de cada proveedor no pueden esconderse sin perder funcionalidad. En consecuencia, en muchos escenarios de multi-cloud la estrategia no es ocultar las diferencias, sino gestionarlas activamente para aprovechar las fortalezas específicas de cada proveedor. Herramientas como Pulumi ejemplifican un modo intermedio con un lenguaje de propósito general para la gestión de infraestructura, más flexible que un lenguaje específico de infraestructura pero sin acoplarse automáticamente al código de aplicación. Pulumi sirve para construir «pegamento» en la nube, pequeños programas que coordinan recursos sin sacrificar las ventajas del desacoplamiento. Para los desarrolladores, arquitectos y responsables técnicos, un buen ejercicio antes de adoptar una nueva tecnología o paradigma es evaluar cómo influye en el acoplamiento de sus sistemas.

Incrementar el acoplamiento debería estar justificado por beneficios sustanciales, ya que las desventajas sobre la flexibilidad, escalabilidad y mantenimiento a largo plazo son significativas. En conclusión, el desacoplamiento sigue siendo una lección fundamental en la ingeniería de software y en la gestión tecnológica moderna. Su aplicación aumenta la robustez, la adaptabilidad y la capacidad de innovación de los sistemas, permitiendo que estos sobrevivan al paso del tiempo y a la evolución constante del mercado y la tecnología. A pesar de la tentación de soluciones que prometen simplificar mediante la integración rígida de componentes, las experiencias y evidencias demuestran que mantener los sistemas desacoplados es la estrategia más segura y poderosa para afrontar los desafíos tecnológicos del presente y futuro.