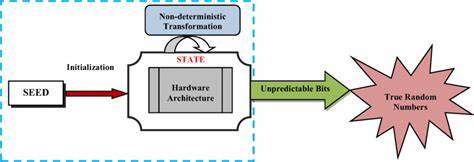

En el mundo moderno, donde la aleatoriedad juega un papel crucial en diversas aplicaciones tecnológicas y científicas, los generadores de números aleatorios verdaderos se han convertido en una herramienta esencial. A diferencia de los generadores pseudoaleatorios clásicos, que dependen de algoritmos matemáticos y semillas iniciales para producir secuencias que parecen aleatorias, los generadores verdaderos se basan en fenómenos físicos impredecibles para crear números con una aleatoriedad genuina. En 2013, la discusión sobre estos dispositivos alcanzó un punto relevante debido a avances, problemas detectados en equipos y aplicaciones prácticas que demandan altos estándares de calidad y seguridad. Estos dispositivos hardware suelen funcionar amplificando el ruido térmico inherente a componentes electrónicos como resistencias o diodos semiconductores. Este ruido, conocido como ruido Johnson, es una manifestación natural y caótica del movimiento térmico de electrones, lo que brinda una fuente física para obtener bits aleatorios.

Posteriormente, una señal que codifica estos eventos se procesa mediante comparadores o triggers de Schmitt, generando bits binarios que, idealmente, son estadísticamente independientes. La combinación de estos bits se traduce en bytes o números de cualquier otro formato apropiado para el uso final. La ventaja principal de emplear este método radica en la verdadera aleatoriedad de los números generados, algo inalcanzable con simples algoritmos computacionales. En contraste, los generadores pseudoaleatorios, omnipresentes en las computadoras actuales, dependen de algoritmos determinísticos que, aunque eficientes y rápidos, tienen limitaciones inherentes en la cantidad de combinaciones y en la previsibilidad. A pesar de que para la mayoría de simulaciones y procesos estadísticos estos sistemas funcionan adecuadamente, surgen dudas respecto a su eficacia en aplicaciones con exigencias extraordinarias, como simulaciones de cadenas de Markov, análisis de series temporales complicadas o incluso en contextos de aprendizaje automático.

La posibilidad de que patrones ocultos o ciclos regulares comprometan la integridad del proceso es una preocupación latente. Por ello, la preferencia por generadores verdaderos, incluso como método de verificación cruzada, es evidente en ciertos sectores. Un caso práctico relevante es el uso de estos generadores en el ámbito de las loterías, donde la equidad y seguridad del proceso son fundamentales. Tradicionalmente, las loterías utilizadas físicas resultados basados en dispositivos como contenedores con bolas numeradas que se extraían al azar. Sin embargo, la tendencia hacia sistemas computarizados ha generado la necesidad de garantizar que la simulación digital reproduzca fielmente la aleatoriedad del sorteo tradicional.

Este escenario impone requisitos específicos: la probabilidad de cada conjunto de números debe ser uniforme y equivalente a la de la extracción clásica, la imprevisibilidad debe ser absoluta para cualquier individuo implicado en el proceso y debe evitarse cualquier manipulación externa o interna que pudiera favorecer ciertos resultados. Además, la certificación por especialistas independientes que valide estas condiciones se vuelve mandatoria, reforzada por legislaciones específicas. La experiencia y análisis revelan que, para cumplir a cabalidad estos estándares, los generadores pseudoaleatorios se quedan cortos, incluso los más avanzados, debido a la limitación en el número de estados posibles y la dificultad para probar matemáticamente que todas las combinaciones se pueden obtener con igual probabilidad. Por ejemplo, con un generador que solo maneja hasta 2 elevado a 31 estados, es imposible llegar a la multitud de combinaciones posibles en un sorteo complejo. Además, la posibilidad de que quienes tengan acceso al código puedan identificar combinaciones más probables agrega un factor de riesgo.

Así, la recomendación ha sido la utilización de generadores hardware de ruido verdadero para basar las loterías computarizadas, delegando al software la función principal de manejo que purifique y valide el correcto uso de estos números. Uno de los estudios más influyentes en la evaluación de generadores aleatorios ha sido el trabajo de George Marsaglia. Su propuesta, además de desarrollar pruebas rigurosas conocidas como "Diehard tests", incluyó la recopilación y distribución masiva de secuencias aleatorias combinando diferentes fuentes de ruido y algoritmos. Sin embargo, un punto crítico identificado fue un error en el manejo de archivos digitales, que provocó fallas significativas en varios generadores hardware que proporcionó. Este episodio puso en relieve la importancia no solo del dispositivo físico, sino de la correcta implementación informática para asegurar la integridad de los datos generados.

Al analizar específicamente los dispositivos disponibles hacia 2013, se detectaron variaciones notables en calidad y desempeño. El generador canadiense, basado en la tecnología de ruido térmico con ocho unidades simultáneas, mostró un leve sesgo en algunos bits y un bajo nivel de correlación, ambas condiciones esperables y mejorables mediante técnicas como la combinación mediante xor de bytes consecutivos. Por otro lado, el generador alemán presentó problemas más profundos, con desviaciones extremas en la distribución de bits y fuertes correlaciones periódicas, probablemente por interferencias electromagnéticas mal gestionadas. Finalmente, el equipo californiano se mantuvo en un desempeño intermedio, con un sesgo pequeño pero con patrones complejos de correlación cruzada difíciles de interpretar, lo que sugiere implementaciones sofisticadas con consecuencias no completamente controladas. Una cuestión crucial en el mundo de estos generadores es la velocidad de producción de números aleatorios.

Mientras que para aplicaciones como loterías o generación de claves para criptografía la velocidad usualmente no es un gran limitante, en simulaciones estadísticas masivas, la capacidad de generar grandes cantidades de datos sin perder calidad es fundamental. En este sentido, muchos de los dispositivos probados alrededor del 2013 mostraban limitaciones, con tasas típicas que iban desde unos pocos miles hasta decenas de miles de bytes por segundo, insuficientes para procesos exigentes. Una solución práctica fue la generación continua en equipos dedicados y el almacenamiento en discos para su uso posterior, aunque esta solución añade un grado de complejidad logística. Además de los problemas técnicos y operativos, los fabricantes de estos dispositivos han demostrado distintos niveles de compromiso con la calidad. Algunos, como los desarrolladores del generador de Colorado, mostraron una clara preocupación por la comprensión de los sesgos y las correlaciones, diseñando sistemas que minimizan estas deficiencias.

Otros, en cambio, afrontaron problemas de ensamblaje y durabilidad, con unidades defectuosas que perdieron su potencia real tras poco tiempo de uso. La difusión y actualización de software, la claridad en la documentación y la transparencia en los procesos de calidad independiente se posicionaron como aspectos clave para la adopción y confianza en estos sistemas. La utilidad en ámbitos criptográficos también destacó por su importancia creciente. La generación de claves verdaderamente aleatorias, indispensables para asegurar la seguridad en sistemas de cifrado, demanda fuentes de elevada calidad y fiabilidad. La posibilidad de generar claves imprevisibles y sin patrones detectables reduce la vulnerabilidad frente a ataques sofisticados que puedan limitar la búsqueda a conjuntos predecibles.

En este campo, los generadores hardware son un complemento muy valorado para fortalecer la robustez de la seguridad. Para quienes buscan integrar o mejorar la generación aleatoria, la recomendación general al 2013 era emplear generadores hardware de la mayor calidad posible y combinar sus salidas con generadores pseudoaleatorios para corregir sutiles desviaciones y correlaciones remanentes. Este enfoque hibrido maximiza las ventajas de ambos métodos, garantizando alta aleatoriedad real y eficiencia práctica. En conclusión, la tecnología de generadores de números aleatorios verdaderos se encuentra en una etapa crucial, en donde sus beneficios son evidentes pero aún existen desafíos técnicos, prácticos y de certificación en su plena implementación. La importancia creciente de la aleatoriedad en todo tipo de disciplinas y aplicaciones continúa impulsando su desarrollo y perfeccionamiento.

La capacidad para detectar sesgos, gestionar corruptelas de datos, mejorar la velocidad y garantizar la confiabilidad, serán aspectos que definirán el futuro inmediato de estos dispositivos y su integración en sistemas críticos de la sociedad digital.