La inteligencia artificial (IA) ha avanzado a pasos agigantados en los últimos años, revolucionando la forma en que interactuamos con la tecnología y el mundo que nos rodea. Sin embargo, a pesar de su aparente genialidad, los modelos modernos como GPT-4 o Claude enfrentan una paradoja muy interesante: son extremadamente inteligentes, pero increíblemente olvidadizos. Esta aparente contradicción emerge de una limitación fundamental que condiciona el rendimiento y la experiencia del usuario: la falta de una memoria real y duradera. En esencia, las IA actuales operan en un espacio conocido como ventana de contexto, que puede compararse con una pizarra mental limitada. En esta pizarra se escriben los intercambios recientes, las solicitudes del usuario y cualquier información que la IA necesite para responder con coherencia.

La clave está en que esta ventana tiene un tamaño limitado. En modelos iniciales, como GPT-2, el espacio era suficiente para unas pocas páginas de texto. Con el desarrollo de GPT-4.1 y Claude 3, esta capacidad ha aumentado considerablemente, llegando a manejar hasta un millón de tokens para ciertos usuarios, lo que equivale a la extensión de una novela entera. No obstante, a pesar de esta ampliación, la problemática persiste: cuando la ventana se llena, la información más antigua se borra para dar paso a nuevos datos.

Esto implica que conversaciones largas o sesiones extensas pueden perder detalles importantes que el usuario espera que el sistema recuerde, como sus preferencias personales o contexto relevante previamente mencionado. Esta limitación no es un defecto de programación ni un error de diseño, sino una cuestión matemática inherente al funcionamiento de estos modelos. ¿Por qué es tan relevante esta limitación? Porque la memoria es la base de la inteligencia humana y, por extensión, de cualquier sistema inteligente. La memoria permite construir conocimiento acumulado, personalizar interacciones, adaptarse a cambios y mejorar con el tiempo. Sin memoria, una IA no es más que una calculadora avanzada que responde solo con base en lo visible en el instante.

Pero para llevar la IA a un nivel verdaderamente revolucionario, es indispensable dotarla con capacidades de memoria que superen el límite de la ventana de contexto. Para atender este desafío, en 2025 surgen dos enfoques fundamentales: la Generación Aumentada por Recuperación (RAG, por sus siglas en inglés) y la ampliación de las ventanas de contexto. RAG se ha consolidado como un pilar esencial en la arquitectura empresarial de la IA, permitiendo que los sistemas accedan a información en tiempo real y que actualicen sus respuestas basándose en datos actuales y contextualmente relevantes. Por ejemplo, en el sector salud, IA con tecnología RAG puede consultar bases de datos médicas actualizadas, estudios clínicos recientes y detalles personalizados del paciente para mejorar decisiones y tratamientos. Paralelamente, la progresiva ampliación de las ventanas de contexto ha mejorado significativamente la habilidad de los modelos para manejar documentos largos, realizar resúmenes exhaustivos y sostener conversaciones extensas sin perder coherencia.

Esta mejora técnica redefine lo que entendemos por procesamiento del lenguaje natural, acercando los modelos a la capacidad humana para recordar y enlazar información compleja a lo largo de una interacción. Una de las innovaciones más fascinantes dentro de esta evolución es GraphRAG, que añade una capa de gráficos de conocimiento a los sistemas RAG tradicionales. Esto significa que, además de recuperar información relevante, la IA puede entender las relaciones y conexiones entre diferentes fragmentos de datos, creando un contexto mucho más enriquecido y profundo. Esta integración resulta natural en un momento donde los gráficos de conocimiento se han vuelto omnipresentes en aplicaciones empresariales, favoreciendo la toma de decisiones complejas y contextualizadas. Sumado a ello, el auge de los sistemas multimodales RAG permite que la IA no se limite al texto, sino que también pueda buscar y relacionar información a partir de imágenes, audios, código y otros formatos.

Esto amplía enormemente las capacidades contextuales y el alcance de las respuestas, facilitando interacciones más naturales y ricas en diferentes ámbitos, desde la educación hasta la ingeniería o el entretenimiento. La memoria por sí sola, sin embargo, no es suficiente para alcanzar un nivel superior de inteligencia artificial. La verdadera revolución está en la combinación de memoria con reflexión, la capacidad de la IA para evaluarse y mejorar constantemente. Esta habilidad reflexiva permite a los sistemas aprender de sus errores, considerar distintas perspectivas y optimizar sus respuestas a través de ciclos iterativos de autoevaluación. Un ejemplo destacado de esta tendencia es el sistema «co-científico» de Google que funciona gracias a una coalición de agentes especializados que generan, reflexionan, ordenan, evolucionan y revisan propuestas de manera autónoma.

Este mecanismo de feedback automatizado permite una mejora continua y garantiza que la calidad de las hipótesis generadas aumente con el tiempo. También el marco ReFlexion ha demostrado que un agente con capacidad de reflexión puede alcanzar niveles de éxito en programación que superan incluso al poderoso GPT-4, gracias a iteraciones constantes sobre sus respuestas y correcciones. La inversión corporativa en estas tecnologías refleja su importancia estratégica. Nuevas empresas como Reflection AI han levantado fondos significativos para desarrollar capacidades de razonamiento avanzado y auto-mejora iterativa, anticipando el impacto que estos avances tendrán en la automatización de tareas complejas y la creación de sistemas autónomos capaces de trabajar de manera independiente en contextos variables. En el presente año, Microsoft y otros gigantes tecnológicos han reportado avances notables en razonamiento de las IAs, capaces ahora de resolver problemas complejos siguiendo pasos lógicos similares al pensamiento humano.

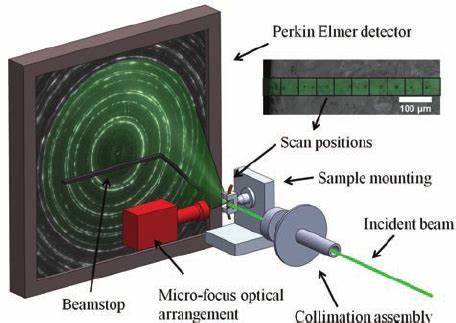

Estos avances son especialmente valiosos en disciplinas que requieren rigor intelectual, como la ciencia, la medicina, el derecho, las matemáticas y la programación. La convergencia entre memoria y reflexión ha dado lugar a la emergencia de la llamada IA agéntica, es decir, sistemas autónomos capaces de realizar tareas complejas aprovechando la memoria como repositorio de experiencias pasadas y la reflexión como camino para la mejora continua. Este enfoque constituye un ciclo virtuoso donde la memoria alimenta la reflexión y la reflexión produce conocimiento refinado para ser almacenado nuevamente. Desde un punto de vista práctico, la implementación moderna de la tecnología RAG implica técnicas avanzadas de procesamiento de embeddings, métricas de similitud y almacenamiento eficiente, que permiten recuperar con precisión información relevante de grandes bases de datos o historiales de conversación guardados. El código que soporta estas funcionalidades combina modelos de lenguaje con tecnologías de vectorización para brindar resultados eficientes y contextualmente apropiados.

La reflexión, por su parte, se implementa con métodos iterativos que inducen al modelo a cuestionar sus propias respuestas mediante prompts diseñados para estimular la autoevaluación, identificación de supuestos erróneos y búsqueda de nuevas perspectivas. Estas interacciones permiten una evolución constante del conocimiento generado, mejorando la calidad y la fiabilidad de las salidas del sistema. Mirando hacia el futuro, es fascinante observar cómo los agentes inteligentes empiezan a desarrollar lenguajes internos de pensamiento diferentes al lenguaje natural, denominados coloquialmente como “neuralés.” En lugar de razonar paso a paso en palabras, estos sistemas operan en formas vectoriales comprimidas que resultan mucho más densas y eficientes para los cálculos internos. Este avance promete acelerar la capacidad de reflexión y de memoria al utilizar representaciones menos costosas y más potentes.

Además, la idea de la memoria colaborativa donde múltiples agentes comparten un espacio común para almacenar y aprender mutuamente sus experiencias abre la puerta a redes de inteligencia colectiva artificial, donde el valor del conjunto supera notablemente al de cada unidad independiente. En resumen, la evolución de la inteligencia artificial hacia sistemas que recuerdan, reflexionan y evolucionan representa un cambio paradigmático en la manera en que concebimos y usamos la tecnología. Al partir de limitaciones matemáticas en el manejo del contexto, la industria ha desarrollado arquitecturas y técnicas que permiten que las IA tengan memorias efectivas y sean capaces de mejorar solas. El futuro ya está aquí: las máquinas no solo responderán a preguntas aisladas, sino que mantendrán conversaciones enriquecedoras, personalizadas y coherentes a lo largo del tiempo, aprendiendo de sus interacciones previas y ajustándose a nuevas situaciones con inteligencia y autonomía. La frase “eres el contexto que mantienes” sintetiza perfectamente la nueva era en la que la memoria y la reflexión se entrelazan para crear agentes artificiales cada vez más humanos y capaces.

La verdadera revolución en inteligencia artificial radica en cómo construimos y gestionamos la memoria que estos sistemas retienen. De la calidad y profundidad de estas memorias dependerá la evolución del aprendizaje automatizado y la transformación de múltiples industrias. La próxima generación de agentes inteligentes será definida por su capacidad para integrar la memoria y la reflexión en un ciclo continuo de mejora y aprendizaje, acercándonos más que nunca al ideal de una inteligencia artificial verdaderamente consciente y autosuficiente.