Los agentes de inteligencia artificial (IA) están transformando la manera en que interactuamos con la tecnología y gestionamos tareas complejas, automatizadas y en tiempo real. Estas aplicaciones avanzadas, alimentadas principalmente por modelos de lenguaje de gran escala (LLM), funcionan de manera autónoma para recopilar datos, analizar información y ejecutar acciones específicas sin necesidad de supervisión humana constante. A medida que su adopción se expande en diversos sectores, desde la atención al cliente hasta las finanzas y la salud, también emergen importantes desafíos relacionados con la seguridad y la integridad de estos sistemas. El concepto de agentes de IA se basa en la capacidad de estos programas para integrar funciones externas o herramientas especializadas, como APIs, bases de datos o servicios de terceros. Esta arquitectura les permite planear, razonar y ejecutar acciones complejas para cumplir objetivos específicos.

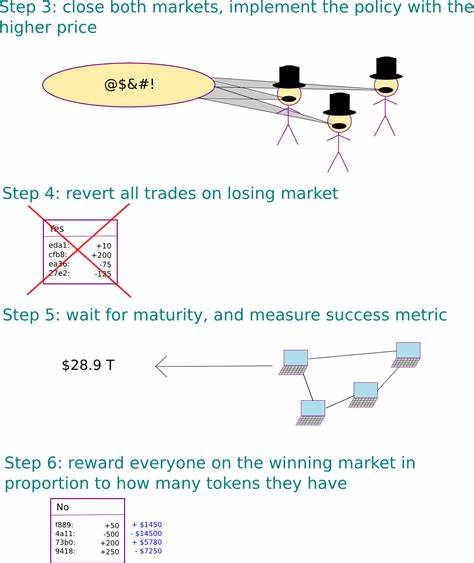

Por ejemplo, un agente puede acceder a bases de datos de mercado financiero, extraer noticias relevantes y realizar operaciones bursátiles automatizadas para optimizar una cartera de inversión. Sin embargo, esta interconexión también amplía la superficie de ataque, ya que cada herramienta integrada puede convertirse en un punto vulnerable si no se maneja correctamente. Las vulnerabilidades en agentes de IA no solo derivan de fallos inherentes a los modelos de lenguaje, sino también de problemas de diseño, configuraciones incorrectas y el uso inseguro de herramientas externas. Uno de los riesgos más destacados es la inyección de prompts o instrucciones maliciosas que alteran el comportamiento esperado del agente, llevándolo a revelar información sensible, ejecutar comandos no autorizados o incluso tomar decisiones perjudiciales. A diferencia de los sistemas tradicionales, donde los ataques a menudo requieren acceso directo o explotación de software, en agentes de IA estas amenazas pueden aprovechar la manipulación del lenguaje natural y la contextualización para lograr sus objetivos.

Entre los escenarios de ataque más preocupantes se encuentran aquellos que permiten la filtración de datos confidenciales mediante la manipulación de las instrucciones del agente o la explotación de herramientas integradas. Por ejemplo, un atacante puede inducir al agente a ejecutar código malicioso en un entorno de interpretación que no esté correctamente aislado, con lo que podría acceder a archivos protegidos, credenciales o incluso tokens de acceso a servicios en la nube. La explotación de estas brechas puede desencadenar desde el robo de identidad hasta la usurpación de infraestructuras enteras. Asimismo, la comunicación entre múltiples agentes, que puede formar parte de sistemas colaborativos más complejos, representa otro vector de ataque. La contaminación de mensajes o la inserción de información controlada por el atacante dentro del flujo de comunicación puede sabotear la coordinación interna, provocar respuestas erróneas, o introducir sesgos y manipulaciones en las decisiones colectivas de la red de agentes.

Para enfrentar estas amenazas emergentes, es fundamental implementar una defensa en profundidad que abarque desde el diseño del prompt, la validación estricta en la entrada de datos, hasta el monitoreo y control en tiempo real de las actividades de los agentes y sus herramientas asociadas. El fortalecimiento del prompt, por ejemplo, busca delimitar el alcance y las respuestas permitidas de cada agente, evitando que incluyan datos sensibles o accedan a funciones fuera de sus responsabilidades. La filtración de contenido, aplicada en forma de filtros que examinan el tráfico de entrada y salida de los agentes, se ha convertido en una capa crítica para detectar intentos de inyección y explotación. Estos filtros pueden identificar patrones sospechosos, solicitudes no autorizadas o incluso fragmentos de código malicioso antes de que el agente los procese o ejecute. Adicionalmente, la sanitización de las entradas a las herramientas es vital para evitar vulnerabilidades clásicas como inyección SQL, ejecución remota de código o desbordamientos que puedan comprometer los sistemas.

Cada función debe validar rigurosamente el formato, tipo y rango de datos recibidos, evitando confiar únicamente en la aparente legitimidad de las solicitudes generadas desde los agentes. Los análisis de seguridad continua mediante técnicas como el análisis estático (SAST), dinámico (DAST) y el análisis de composición de software (SCA) permiten identificar puntos débiles en las dependencias, el código o las configuraciones que los agentes utilizan. Esto garantiza que las herramientas integradas no contengan vulnerabilidades conocidas que puedan ser explotadas por atacantes sofisticados. El sandboxing efectivo para la ejecución de código dinámico es otro componente indispensable. Las configuraciones por defecto de muchos entornos de contenedores no son suficientes para impedir que un código malicioso se escape y afecte recursos críticos.

Para evitarlo, se deben restringir las capacidades del sistema operativo, limitar el acceso a la red interna, excluir volúmenes sensibles y aplicar cuotas de CPU y memoria para prevenir abusos y ataques de denegación de servicio. Frente a estos retos, diversas soluciones tecnológicas han emergido para proteger entornos con agentes de IA. Plataformas como Prisma AIRS (AI Runtime Security) ofrecen protección en tiempo real mediante análisis inteligente de tráfico de red y comportamiento de aplicaciones, detectando ataques avanzados como la inyección de prompts, exfiltración de datos y denegación de servicio. Complementariamente, AI Access Security brinda visibilidad y control sobre el uso de sistemas de inteligencia artificial de terceros, ayudando a mitigar riesgos asociados a contenido malicioso o el uso inadvertido de herramientas inseguras. Los ataques simulados en aplicaciones de asesoría financiera desarrolladas con frameworks populares como CrewAI y AutoGen evidencian que la mayoría de las vulnerabilidades no dependen del framework en sí, sino del diseño del sistema, la configuración de los agentes y la integración de herramientas externas.

Estos estudios destacan la necesidad de entender que las amenazas son sistémicas y que las medidas defensivas deben ser holísticas y coordinadas para ser efectivas. Es importante destacar que las amenazas no se limitan a técnicas sofisticadas o actores altamente organizados. Cualquier usuario malintencionado puede intentar manipular la entrada del sistema para obtener información restringida o inducir comportamientos no deseados. Por ello, la defensa debe estar diseñada para la resiliencia ante diversos tipos de intentos de explotación, desde ataques directos hasta vectores indirectos como la contaminación de fuentes de información externas. La creciente dependencia de agentes de IA en sectores críticos como la salud, las finanzas o la infraestructura nacional convierte la seguridad de estos sistemas en una prioridad estratégica.