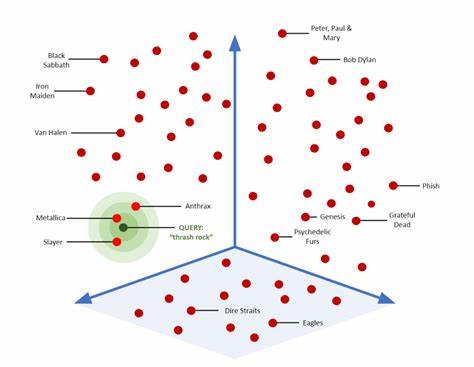

En el entorno actual dominado por la inteligencia artificial y la explosión de datos, el concepto de búsqueda vectorial ha captado la atención de muchas empresas y desarrolladores. Las bases de datos de búsqueda vectorial prometen revoluciones en la manera en que se recupera la información, especialmente en sistemas que manejan datos como texto, imágenes o audio transformados en vectores. Sin embargo, surge la pregunta crucial: ¿realmente necesitas una base de datos de búsqueda vectorial para tu proyecto o negocio? Este análisis profundiza en esa interrogante, basándose en experiencias prácticas, consideraciones técnicas y una evaluación del ecosistema actual. La aparición de plataformas especializadas en búsqueda vectorial como Pinecone, Milvus, Qdrant y Weaviate ha sido un catalizador para la innovación en este ámbito. Estas herramientas, tanto open source como gestionadas, prometen escalabilidad, flexibilidad y rapidez que superan muchas soluciones tradicionales, ofreciendo capacidades avanzadas para manejar millones de vectores de alta dimensión.

Su crecimiento en popularidad también ha generado un debate importante sobre la complejidad operativa, los costos y la curva de aprendizaje que su adopción implica. Para entender si realmente conviene migrar o implementar una base de datos vectorial, es útil examinar casos prácticos. Un ejemplo ilustrativo lo encontramos en Intercom, una empresa que decidió evaluar detenidamente sus opciones antes de adoptar esta tecnología. Inicialmente, su sistema de recuperación basado en memoria trabajaba con cargas almacenadas en S3 y usaba búsquedas KNN (K Nearest Neighbors) mediante algoritmos de fuerza bruta. Si bien esta solución funcionaba para volúmenes menores, el crecimiento masivo de embeddings (representaciones vectoriales) generó latencias insoportables y cuellos de botella en la carga de datos.

Esta realidad evidenció la necesidad de buscar una solución más robusta y eficiente. Antes de comprometerse con alguna tecnología en específico, los responsables del proyecto definieron criterios claros y exigentes. La escala era un factor clave, apuntando a una gestión eficiente de más de cien millones de vectores con dimensiones que crecerían con el tiempo. Además, el costo total, no solo en infraestructura sino también en operación continua, debía ser sostenible. Otro requisito importante fue la capacidad de aplicar filtros durante las búsquedas para respetar permisos y segmentar la información según idioma, tipo de contenido o audiencia, algo imprescindible para plataformas complejas con múltiples usuarios.

La selección de la solución adecuada también estuvo marcada por la necesidad de evitar cargas operativas innecesarias, preferir herramientas que tuvieran un soporte sólido en búsqueda textual para garantizar una funcionalidad híbrida y, sobre todo, optar por tecnologías sólidas y conocidas para asegurar monitoreo, mantenimiento y escalabilidad predecibles. Ante este escenario, Intercom evaluó las opciones disponibles en el mercado, incluyendo las mencionadas bases especializadas y Elasticsearch, una plataforma tradicionalmente usada para la búsqueda textual. Aunque las bases vectoriales especializadas ofrecían características avanzadas, su adopción implicaba un riesgo operativo considerable y costos elevados, especialmente en las versiones gestionadas. Elasticsearch, por otro lado, representaba una opción familiar y probada, con ventajas estratégicas notables. Esto se debe a que ya era una pieza clave en sus sistemas esenciales, facilitando su integración, gestión y mejora continua.

Para validar esta preferencia, realizaron pruebas de benchmarking con conjuntos de datos que simulan condiciones reales. Los resultados mostraron que Elasticsearch ofrecía latencias que iban desde unos pocos milisegundos para decenas de miles de vectores hasta aproximadamente 100-200 milisegundos a mayor escala. Aunque no era el más rápido del sector, estaba en un rango adecuado si se considera que el proceso de inferencia con modelos de lenguaje grande (LLM) tiene latencias propias que superan ampliamente ese tiempo, haciendo imperceptible cualquier mejora menor en la búsqueda vectorial. La decisión final consideró varios factores que fueron más allá de los números puros. El bajo costo de infraestructura, especialmente al compartir recursos con el clúster ya en operación, significó un ahorro importante.

La familiaridad del equipo con Elasticsearch redujo la curva de aprendizaje y evitó la necesidad de elaborar nuevas guías operativas o enfrentar problemas comunes en sistemas distribuidos novedosos. Además, se beneficiaron del conocimiento experto interno para ajustar parámetros como el tamaño y número de shards o la capacidad de los nodos, lo que optimizó el rendimiento y la estabilidad. Un elemento distintivo fue la capacidad de Elasticsearch para combinar búsquedas vectoriales con filtros estructurados y búsqueda textual, una característica que muchas bases vectoriales puras no satisfacen con la misma facilidad. Esta combinación habilita un enfoque híbrido que puede mejorar la relevancia y personalización de los resultados, facilitando futuras mejoras. La implementación en producción mostró beneficios contundentes.

El tráfico y la escala superaron las estimaciones iniciales tres veces, manejando hasta 300 millones de embeddings en dimensiones aumentadas, con un costo mensual razonable y una gestión estable. Las métricas de latencia mejoraron notablemente, ofreciendo una experiencia de usuario más ágil, especialmente para clientes con grandes volúmenes de datos. La robustez operativa permitió absorber picos de carga y crecimiento sin problemas mayores, manteniendo un operativo conocido y fiable. Como conclusión valiosa, el recorrido de Intercom invita a reflexionar sobre principios fundamentales para tomar decisiones tecnológicas de este tipo. Aprovechar la experiencia existente es una ventaja crucial para acelerar la implementación y minimizar riesgos.

Es necesario reconocer que la tecnología líder o más novedosa no siempre es la opción óptima si implica costos operativos o complejidad desproporcionados. Asimismo, las ventajas en rendimiento deben medirse frente a su impacto real en la experiencia y el negocio, donde diferenciales mínimos pueden ser irrelevantes. Finalmente, el análisis sugiere que una solución etiquetada como “convencional” o menos emocionante puede ser la más adecuada para muchos casos, brindando balance entre capacidad técnica, costos y estabilidad. Sin embargo, no se trata de descartar innovaciones, sino de evaluar cuidadosamente si su adopción agrega valor tangible y si la organización está preparada para gestionarlas. En definitiva, no todas las implementaciones requieren una base de datos vectorial especializada.

En ocasiones, un sistema robusto y conocido como Elasticsearch con capacidades vectoriales ofrece el equilibrio ideal. La clave está en entender tus necesidades, las características de tus datos y demandas, y elegir la solución tecnológica que armonice con tus recursos y objetivos estratégicos.