En el dinámico mundo de la inteligencia artificial, la percepción visual se ha convertido en un pilar fundamental para el desarrollo de sistemas inteligentes que entienden y reaccionan ante su entorno de manera similar a los seres humanos. Meta, a través de su equipo de Investigación Fundamental en IA (FAIR), ha dado un paso significativo con el lanzamiento de Meta Perception Encoder, un avanzado encoder de visión diseñado para establecer nuevos estándares en la combinación de visión y lenguaje, mejorando la precisión y capacidad de interpretación en imágenes y videos. Al capturar y procesar información visual con gran detalle, Meta Perception Encoder se posiciona como una solución crucial para superar los retos que enfrentan los modelos tradicionales. Su capacidad no solo radica en reconocer objetos o clasificar imágenes, sino en entender escenas complejas donde la sutileza hace la diferencia, como detectar una pequeña ave en el fondo de una fotografía o localizar un pez camuflado en el fondo marino. Esta sensibilidad visual es fundamental para aplicaciones que requieren una precisión extrema y comprensión contextual profunda.

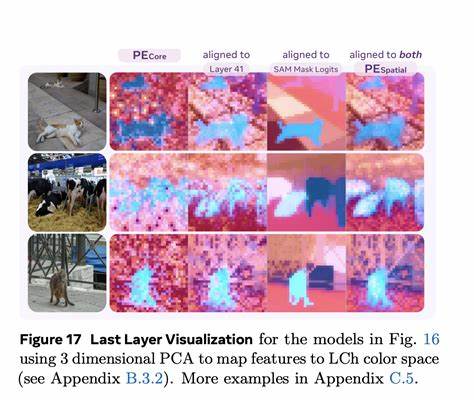

El innovador diseño del Perception Encoder une el procesamiento visual con el alineamiento lingüístico, creando así sistemas que pueden interpretar imágenes y videos en conjunto con descripciones de lenguaje natural. Esta integración permite que las máquinas no solo reconozcan elementos visualmente, sino que también respondan a preguntas visuales, generen descripciones acertadas, entiendan documentos y establezcan relaciones espaciales, capacidades que hasta ahora presentaban grandes desafíos para otros modelos de visión y lenguaje. La versatilidad del Perception Encoder es evidente en su desempeño sobresaliente en clasificación y recuperación de imágenes y videos sin necesidad de entrenamiento específico para cada tarea, conocido como zero-shot. Esta característica abre la puerta a aplicaciones prácticas inmediatas que demandan respuestas rápidas y precisas sin la carga de enormes bases de datos etiquetadas para calibrar el modelo para cada situación. Además, el Perception Encoder destaca en tareas tradicionalmente difíciles para los modelos de lenguaje, como determinar si un objeto está detrás de otro o evaluar el movimiento de la cámara que captura una escena.

Estas habilidades reflejan un avance considerable en la comprensión espacial y temporal del entorno, fundamentales para robots, asistentes virtuales y sistemas automáticos que interactúan con el mundo real. La liberación pública del modelo, junto con el código y los datos de entrenamiento, representa un compromiso hacia una comunidad investigadora abierta y colaborativa. Este acceso permite a investigadores y desarrolladores de todo el mundo explorar, mejorar y adaptar la tecnología para una variedad de usos en sectores tan diversos como la seguridad, la automoción, la medicina y la vida cotidiana. Pero el progreso no termina con el Perception Encoder. En línea con esta iniciativa, Meta ha presentado también otros desarrollos complementarios que enriquecen el panorama de la percepción artificial, tales como el Perception Language Model, capaz de abordar desafíos complejos en reconocimiento visual mediante un entrenamiento masivo con datos sintéticos y humanos, y Meta Locate 3D, un modelo pionero en la localización de objetos en entornos tridimensionales a partir de consultas en lenguaje natural.