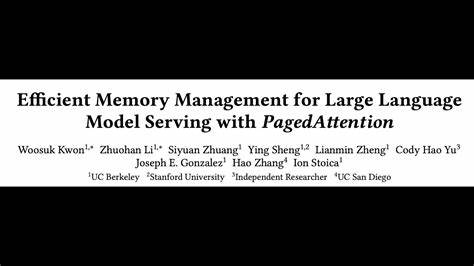

En la era de la inteligencia artificial avanzada, el uso de modelos de lenguaje grandes (LLMs) se ha convertido en una pieza fundamental para numerosas aplicaciones, desde asistentes virtuales hasta traducción automática y generación de contenido. Sin embargo, una de las mayores barreras para la adopción masiva y eficiente de estos modelos está relacionada con la gestión de la memoria durante su ejecución, especialmente en entornos donde se requiere ofrecer servicios en tiempo real y alta concurrencia. Para afrontar este desafío, el novedoso enfoque de PagedAttention ofrece una solución ingeniosa y efectiva inspirada en las técnicas clásicas de paginación de memoria usadas en sistemas operativos, mejorando significativamente el manejo del cache de claves y valores (KV cache) en la atención de los LLMs. Los modelos de lenguaje grandes funcionan principalmente mediante la arquitectura Transformer, la cual depende en gran medida del mecanismo de atención para captar relaciones contextuales en los datos secuenciales. Este mecanismo utiliza un cache de claves y valores que crece dinámicamente a medida que se procesan secuencias mayores, generando un consumo considerable de memoria y dificultando la gestión eficiente cuando se atienden múltiples solicitudes simultáneas.

La fragmentación del espacio de memoria y la duplicación redundante de estos caches tienden a limitar la cantidad de solicitudes que se pueden procesar por lotes, disminuyendo así el rendimiento y la escalabilidad. PagedAttention aborda este problema aplicando un concepto proveniente del mundo de los sistemas operativos: la paginación de memoria virtual. Esta técnica divide el almacenamiento en páginas pequeñas y manejables que pueden ser asignadas, compartidas o liberadas dinámicamente según las necesidades del sistema. Adaptar esta estrategia para la gestión del KV cache en la atención de LLMs permite lograr un uso casi perfecto de la memoria, eliminando desperdicios causados por fragmentación y duplicación innecesaria. La implementación práctica de PagedAttention se presenta en vLLM, un sistema de servicio para modelos de lenguaje que optimiza la utilización de memoria mientras mejora el throughput, es decir, la cantidad de solicitudes procesadas en un intervalo de tiempo dado, sin sacrificar la latencia.

Evaluaciones detalladas demuestran que vLLM, al aprovechar PagedAttention, puede lograr un rendimiento 2 a 4 veces superior al de sistemas avanzados actuales como FasterTransformer y Orca, especialmente en escenarios con secuencias largas, modelos de gran tamaño y algoritmos de decodificación complejos. Uno de los aspectos más innovadores de esta solución es la capacidad para compartir el KV cache entre diferentes solicitudes y entre diferentes partes de una misma solicitud. Esta flexibilidad reduce aún más el uso de memoria total y permite manejar lotes con mayor tamaño. En contextos de alta demanda, donde la eficiencia en la asignación de recursos es crítica, vLLM consigue mantener un equilibrio superior entre velocidad y uso eficiente de memoria. Esto se traduce en sistemas más escalables y económicos, facilitando la integración de LLMs en aplicaciones que requieren alta disponibilidad y rápido tiempo de respuesta.

Además de las mejoras técnicas, PagedAttention y el sistema vLLM promueven un avance hacia la democratización del acceso a modelos de lenguaje potentes. Al optimizar los recursos necesarios para servir estos modelos, es más factible que organizaciones de distintos tamaños, incluyendo aquellas con presupuestos limitados, puedan implementar soluciones basadas en LLMs sin comprometer la calidad ni la velocidad. El código fuente de vLLM se encuentra disponible públicamente, lo cual impulsa la colaboración abierta y el desarrollo continuo en la comunidad de inteligencia artificial y sistemas distribuidos. Esto fomenta la experimentación y adopción acelerada de estas técnicas innovadoras, consolidando un ecosistema donde la eficiencia y el acceso democratizado a tecnologías avanzadas son prioridades. En resumen, la gestión eficiente de memoria para modelos de lenguaje grandes es una problemática crítica que afecta directamente el rendimiento y escalabilidad de estos sistemas en producción.

Con la introducción de PagedAttention, se ofrece una solución inspirada en técnicas probadas de sistemas operativos, permitiendo una asignación más inteligente y dinámica de la memoria del KV cache. El resultado es un aumento significativo en la capacidad de procesamiento, reducción de desperdicio y flexibilidad para compartir recursos entre solicitudes, todo esto sin incrementar la latencia. El futuro de la inteligencia artificial conversacional y procesamiento de lenguaje natural se verá beneficiado por desarrollos como PagedAttention, que no solo mejoran la tecnología en sí, sino que también permiten su implementación a mayor escala y con mayor eficiencia económica. Para quienes trabajan en el desarrollo o integración de modelos de lenguaje a gran escala, entender y aplicar estas técnicas representa una ventaja competitiva clave en un mercado cada vez más exigente y dinámico.