En el mundo de la inteligencia artificial y el procesamiento del lenguaje natural, los modelos de lenguaje a gran escala (LLM, por sus siglas en inglés) se han convertido en piezas fundamentales para ofrecer funcionalidades avanzadas, desde la generación de texto coherente hasta la comprensión profunda del contexto lingüístico. Sin embargo, el éxito de estos modelos no radica únicamente en la arquitectura o el tamaño, sino en el tipo y la calidad de los datos que se emplean para entrenarlos. Aquí es donde los conjuntos de datos adquieren una importancia crucial, ya que pueden determinar las capacidades y limitaciones de estos sistemas complejos. El paradigma tradicional para entrenar un modelo de lenguaje solía centrarse en la modelación estadística a partir de grandes cantidades de texto, pero recientemente ha emergido una visión innovadora que enfatiza que los conjuntos de datos por sí solos pueden enseñar al modelo a generar las instrucciones o indicaciones (prompts) necesarias para su propio funcionamiento. Esta aproximación, conocida como "Datasets Are All You Need" (los conjuntos de datos son todo lo que necesitas), se basa en la premisa de que un buen conjunto de datos no solo proporciona información, sino que también codifica la manera en que el modelo debe interactuar con el usuario o con otras tareas.

El proceso es ciertamente revolucionario. Tradicionalmente, los prompts o las indicaciones para un LLM se diseñaban manualmente por expertos, quienes determinaban qué tipo de entrada debía recibir el sistema para ofrecer una salida deseada. Este procedimiento, aunque efectivo, es laborioso, subjetivo y poco escalable. En cambio, cuando el modelo puede aprender directamente desde los datos a reconocer y generar sus propios prompts, se vuelve mucho más adaptable y capaz de generalizar a nuevas tareas o contextos. Un componente crítico de esta metodología es la creación y selección cuidadosa de conjuntos de datos que incluyan ejemplos representativos, variados y contextualizados.

Estos conjuntos de datos no solo contienen datos crudos, sino que están diseñados para reflejar las dinámicas del lenguaje, la variedad de usos y las tareas específicas que el modelo debe dominar. Esto facilita que el LLM comprenda mejor la intención detrás de cada prompt y optimice su respuesta sin intervención humana directa. La generación automática de prompts a partir de datos abre un abanico de posibilidades para la mejora continua y la personalización. Gracias a los conjuntos de datos, los modelos pueden ajustarse a dominios específicos, integrar lenguaje especializado e incluso adaptar su estilo comunicativo en función de finalmente con quién interactúan. Esto no solo incrementa la eficiencia del modelo, sino también la calidad y relevancia de sus respuestas, generando una experiencia mucho más enriquecedora para el usuario.

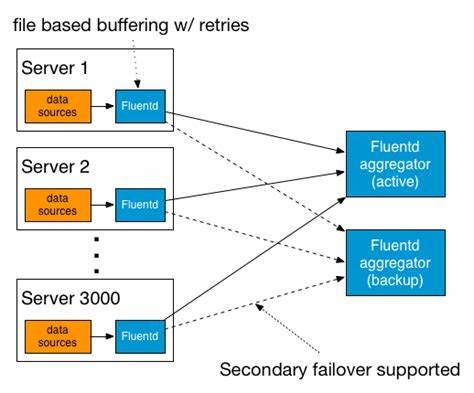

Además, esta estrategia de aprendizaje basada en datos ayuda a mitigar algunos de los riesgos asociados con el diseño manual de prompts, como los sesgos inadvertidos, inconsistencias o limitaciones de creatividad. Los modelos aprenden a partir de una variedad rica y extensa de ejemplos, lo que conduce a una generación de texto más neutral y precisa. Asimismo, facilita el entrenamiento continuo donde cada nuevo conjunto de datos contribuye a mejorar las capacidades del sistema sin necesidad de reinventar las reglas o parámetros desde cero. La implementación práctica de esta filosofía requiere herramientas especializadas para la recopilación, limpieza y gestión de datos. Técnicas como la extracción automática de datos, normalización y anonimización son esenciales para construir conjuntos robustos que mantengan la privacidad y la calidad.

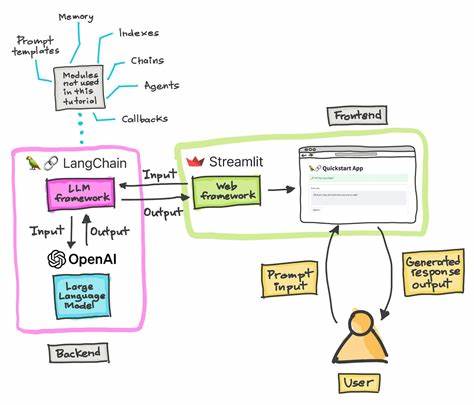

Paralelamente, notebooks y frameworks específicos permiten experimentar con diferentes configuraciones y evaluar el rendimiento de los modelos con base en los conjuntos de datos utilizados. Otro aspecto a destacar es la alineación con tendencias actuales en aprendizaje automático, donde se enfatiza en la automatización y la reducción de la intervención humana para lograr mejores resultados. El concepto de "Datasets Are All You Need" encaja perfectamente con esta visión, evidenciando que, con los datos adecuados, los modelos no sólo mejoran, sino que también emergen con capacidades inesperadas que surgen de su aprendizaje inherente. Esta evolución presenta desafíos, entre ellos la necesidad de garantizar la diversidad y representatividad en los datos para evitar problemas éticos o de equidad en las respuestas generadas. Además, es fundamental contar con mecanismos para evaluar continuamente la calidad de los modelos y sus outputs para asegurar que sigan siendo relevantes y útiles en distintos contextos y aplicaciones.

En conclusión, el papel de los conjuntos de datos en el entrenamiento y funcionamiento de los modelos de lenguaje a gran escala es fundamental y está al centro de una revolución en la forma en que la inteligencia artificial aprende y se adapta. Aprender a partir de los datos para generar prompts propios no solo optimiza el proceso sino que también abre caminos para una interacción más intuitiva, personalizada y eficiente con las máquinas. A medida que la tecnología avanza, la calidad y el diseño inteligente de los conjuntos de datos serán, sin duda, los principales motores que guiarán el futuro del procesamiento del lenguaje natural y, en general, la inteligencia artificial.